Hinter großen Webseiten steckt eine Menge Know-How. Wir von SISTRIX haben es uns seit jeher zur Aufgabe gemacht, SEO-Insider-Wissen aus erster Hand zu teilen. Fünf deutsche SEO-Experten, die die Webseiten führender Unternehmen betreuen, liefern dir exklusive Insights in Sachen SEO für umfassende Projekte.

- Welche besonderen Skills sollte ein SEO für eine große Webseite mitbringen?

- Macht es Sinn, mit Agenturen oder externen Beratern zusammenzuarbeiten?

- SEO in großen Unternehmen - welche Abteilung muss was wissen?

- Wie sieht SEO für große Webseiten in Zukunft aus?

- Welche Strategien sind für das Crawling und die Indexierung großer Websites empfehlenswert?

- Was bringt es, große Mengen an Seiten bewusst zu deindexieren?

- Wie gehe ich bei umfangreichen Webseiten mit der Steuerung und Überwachung des Googlebots um?

- Welche Strategien kann ich nutzen, um Millionen von Seiten mit internen Links zu versorgen?

- Welche Stolpersteine tauchen häufig bei der technischen Umsetzung auf?

- Wie verändern die Brand-Suchen einer starken Marke meine Keywordrecherche?

- Wie kann ich die Zuteilung meines Keyword-Materials so organisieren, dass sich die verschiedenen Formate nicht gegenseitig kannibalisieren?

- Wie kann ich Evergreen-Content skalierbar erstellen, erkennen und ausbauen?

- Was kann ich aus meiner internen Suche lernen?

- Was bringen A/B-Tests?

- Welche Voraussetzungen muss meine Webseite mitbringen, damit eine Internationalisierung mit hreflang möglich wird?

- Wie behalte ich den Überblick über das komplette Projekt und wann lohnt sich eine Auswertung auf Ebene einzelner Keywords?

Dominik Schwarz, Daniel Reeh und Benedikt Kirch sprechen aus eigener Erfahrung: Als langjährige Inhouse-SEOs wissen sie, wie man SEO-Maßnahmen in großen Unternehmen gezielt umsetzt.

Nedim Šabić, freiberuflicher SEO-Berater, und Markus Hövener, Geschäftsführer der Agentur Bloofusion, gewähren uns einen Einblick in die Aufgaben, die die externe SEO-Beratung bereithält.

Welche besonderen Skills sollte ein SEO für eine große Webseite mitbringen?

Geht es um das perfekte SEO-Team, geht es immer auch um eine gute Führung. Ein guter SEO-Teamleader sollte ein umfangreiches Verständnis von technischem SEO haben und die Infrastruktur einer großen Website verstehen.

Gutes SEO erfordert nicht zwingend die eine spezielle Fähigkeit: Technische und inhaltliche Spezialisten sind unverzichtbar, aber erfolgreiche Suchmaschinenoptimierung hat immer auch das Große Ganze im Blick.

Macht es Sinn, mit Agenturen oder externen Beratern zusammenzuarbeiten?

Ein zentraler Vorteil in der Zusammenarbeit mit Agenturen ist die externe Sicht auf die Dinge in einem Unternehmen. Klar ist, dass sich niemand mit der eigenen Website und der technischen Struktur so gut auskennt wie der Inhouse-SEO eines Unternehmens – typischerweise kennt er aber nur eine Fallzahl von 1. Agenturen hingegen haben bereits viele Projekte betreut und einen großen Erfahrungsschatz gesammelt. Sie wissen um Chancen und Risiken, die man als Inhouse möglicherweise nicht sieht.

Unternehmen bündeln nicht alle fachlichen Ressourcen im eigenen Haus. Wenn Expertise gefragt wird, ist die Zusammenarbeit mit einer spezialisierten Agentur die beste Wahl und bietet darüber hinaus die wertvolle Chance, die eigene Strategie auch einmal zu hinterfragen. Damit sind Agenturen eine wichtige Ergänzung im „Ökosystem” Digital-Marketing.

SEO in großen Unternehmen – welche Abteilung muss was wissen?

Die Arbeit eines SEOs betrifft immer auch andere Bereiche eines Unternehmens – umso wichtiger ist eine gelungene Kommunikation unter den verschiedenen Abteilungen. Wenn jeder im Unternehmen das „Grundmantra” von SEO kennt, ist ein wichtiger Schritt bereits getan.

Erfolgreiche Unternehmen verstehen SEO nicht als Abteilung, sondern als Prozess und als wertvollen Kanal für Leads, Konversionen und Umsatz! Mit dieser Erkenntis wird SEO die Aufmerksamkeit im Unternehmen bekommen, die es verdient.

Wie sieht SEO für große Webseiten in Zukunft aus?

Im letzten Video werfen unsere Gäste einen Blick in die SEO-Glaskugel. Wir werden durch die fortschreitende Technologie einen stetigen Zuwachs an neuen SEO-Disziplinen erleben – ähnlich, wie es derzeit die Voice-Search erlebt. SEOs werden sich folglich immer deutlicher spezialisieren und Nischen besetzen (müssen).

SEO für umfangreiche Projekte ist ein spannendes Thema – doch wie lösen führende SEO-Experten technische Probleme rund um Extensive SEO?

Fragen wir sie doch selbst! Wir haben SEOs aus Deutschland, Großbritannien und Spanien zu Rate gezogen und konkrete Fragestellungen in diesem Zusammenhang besprochen.

Neben unseren deutschen Gästen Dominik Schwarz, Daniel Reeh, Benedikt Kirch, Nedim Šabić und Markus Hövener, kommen für Spanien Carlos Redondo, Pedro Martinez, Lakil Essady und Daniel Pinillos zu Wort. Wie man die Dinge in Großbritannien löst, erzählen uns Kirsty Hulse, Alex Moss, Stephen Kenwright und Patrick Langridge.

Welche Strategien sind für das Crawling und die Indexierung großer Websites empfehlenswert?

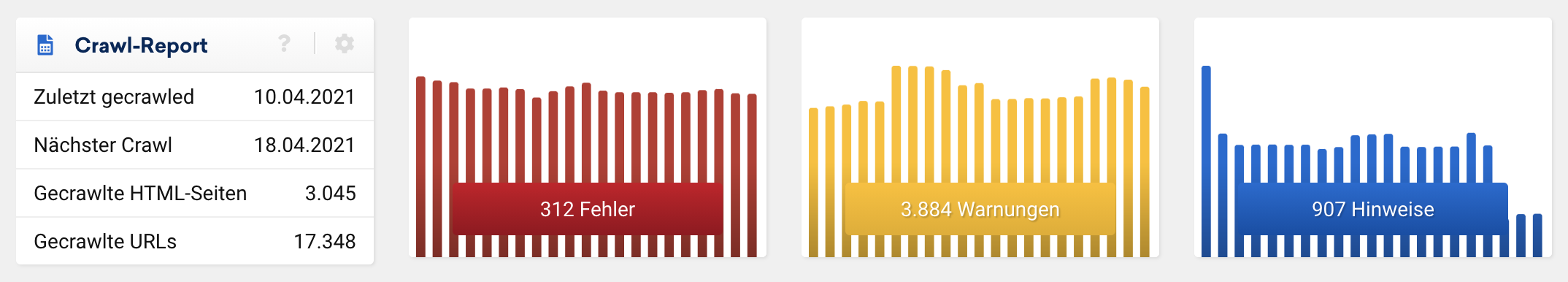

Die erste Frage in Sachen Crawlen und Indexieren sollte lauten: Welche Seiten braucht man tatsächlich, und welche nicht. Unsere Experten sind sich einig, dass eine wohl überlegte Contentproduktion ein mächtiger Hebel für ein zuverlässiges Crawlen und Indexieren ist.

meinestadt.de

Website-Inhalte: So viel wie nötig, so wenig wie möglich.

Ein häufiges Problem beim Crawlen und Indexieren sind doppelte Inhalte, die aufgrund von Filtern und anderen Parametern erstellt wurden. Hier hilft es, Parameter so gut wie möglich in Cookies auszulagern und nicht von Google crawlen zu lassen. Filter und facettierte Navigationen können aktuell noch gut über das PRG-Pattern umgesetzt werden.

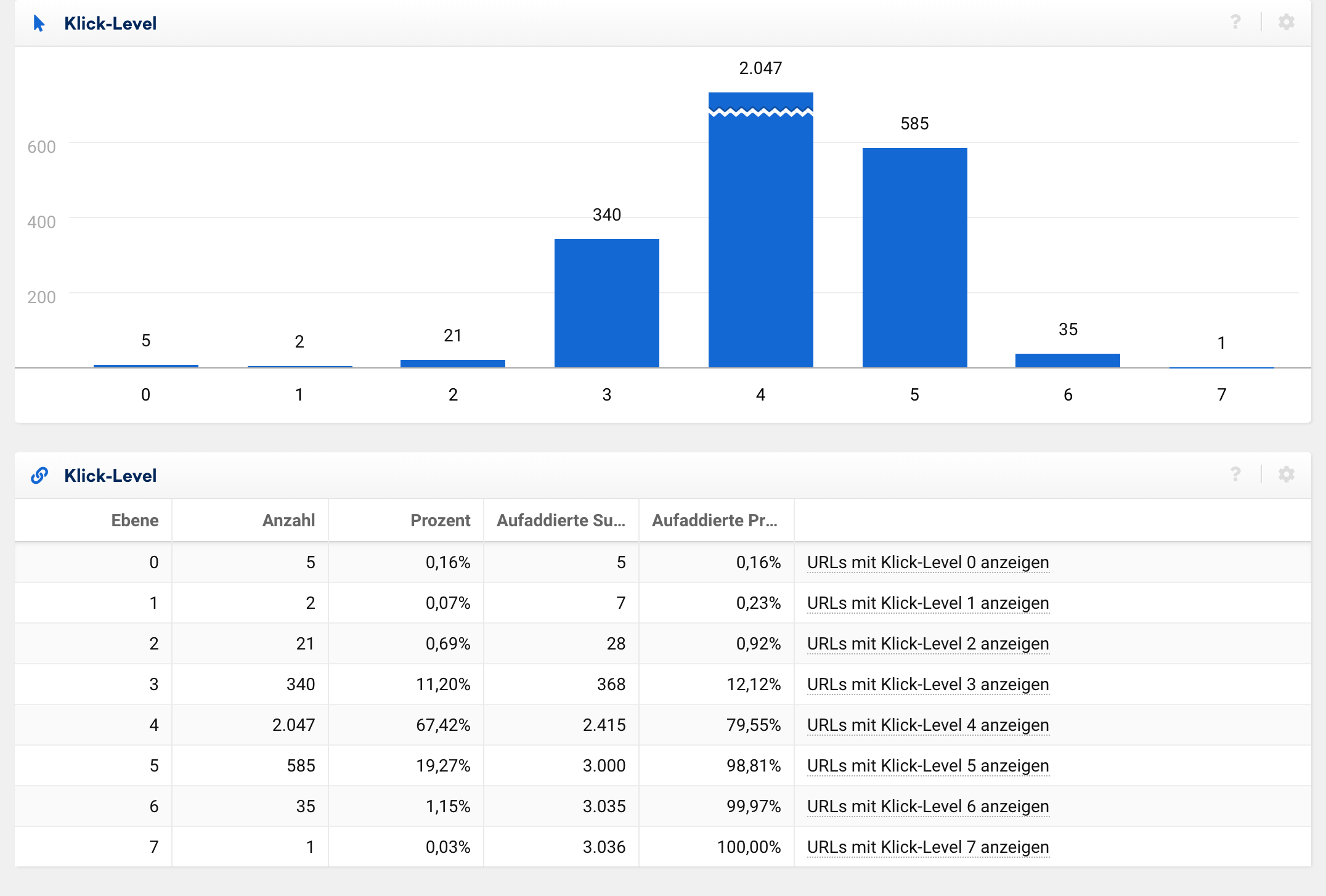

Außerdem sollte man die Klicktiefe der eigenen Seiten im Auge zu halten. Je tiefer ein Inhalt liegt, desto länger braucht der Googlebot, um ihn zu finden.

Besonders bei umfangreichen Webseiten hat sich eine Aufteilung in Themen-Cluster bewährt. Da es bei umfangreichen Webseiten nicht mehr möglich ist, alle Seiten einzeln zu betrachten und zu überprüfen, sollte die Verlinkung innerhalb und zwischen den Clustern systematisch aufgebaut werden.

Die Nutzung von XML-, Bilder-, Video-, und Produkt-Sitemaps hilft dem Googlebot, eine umfangreiche Seite besser zu verstehen. Diese Dateien sollten bei umfangreichen Webseiten nie händisch, sondern immer algorithmisch erstellt werden.

Auch der PageSpeed ist ein Faktor! Durch schnelle Ladezeiten kann der Googlebot mehr Inhalte in der gleichen Zeit und mit den gleichen Ressourcen finden.

Zusammenfassend lässt sich sagen, dass es keine pauschale Lösung für jede umfangreiche Webseite gibt. Ab einer bestimmten Größe wird es jedoch unabdingbar, dass man das eigene System versteht und dessen Kontrolle inne hat.

Was bringt es, große Mengen an Seiten bewusst zu deindexieren?

Die Deindexierung einer großen Anzahl an Seiten der eigenen Domain kann durchaus Vorteile mit sich bringen. Unsere Experten raten auch hier zu einer durchdachten Strategie.

Wenn man sich die Frage stellt, ob bestimmte Seiten oder ganze Bereiche einer Webseite nichts im Google-Index zu suchen haben, ist das Kind schon in den Brunnen gefallen. Besonders bei redaktionell erstellten Beiträgen kann sich eine Überarbeitung lohnen, bevor man Inhalte deindexiert.

hometogo.de

Man sollte sich zwischen „Deindexieren” und „gar nicht erst erstellen” entscheiden.

Das Entfernen großer, unnötiger Teile einer Webseite kann aber auch dazu führen, dass sich die Signale für den Rest der Seiten verbessern. Im Idealfall bleiben nach einer großflächigen Deindexierungsmaßnahme nur noch Seiten übrig, die intern als notwendig eingestuft wurden und damit eine überdurchschnittlich hohe Qualität besitzen.

Sollten hyperdynamische Inhalte der Webseite ihren Weg in den Index gefunden haben, kann man diese durchaus von der Indexierung ausschließen. Ähnlich sieht es bei Parametern und Paginierungen aus. Hier ist es in erster Linie sinnvoll, Änderungen technisch sauber über das eigene System abzubilden. Zudem beeinflusst das noindex-Attribut nur die Indexierung, nicht jedoch den Crawl der Seite.

Die Nutzung von Google-Hacks, wie zum Beispiel der gemeinsamen Nutzung von „noindex” und „follow”, kann kurzfristig ein probates Hilfsmittel sein, ist jedoch zu vermeiden. Hier macht man sich von Googles Verarbeitung dieser Signale abhängig, die sich jederzeit ändern können.

Zu guter Letzt kann eine Verringerung der bestehenden Seiten eine stärkere und vereinfachte interne Verlinkung mit sich bringen, die wiederum dem Crawlen durch den Googlebot zu Gute kommt.

Wie gehe ich bei umfangreichen Webseiten mit der Steuerung und Überwachung des Googlebots um?

Sobald eine Webseite einen Umfang erreicht hat, bei dem man von einer großen Webseite sprechen kann, gewinnt die Steuerung und das Monitoring des Googlebots an Bedeutung.

Die Google Search Console liefert wichtige Einblicke in das Crawlingverhalten des Googlebots auf der eigenen Seite. Google liefert in den Crawling-Statistiken dienliche Informationen dazu, wie viele Unterseiten der Domain an einem Tag gecrawlt wurden. Wenn beispielsweise 1.000.000 URLs auf einer Domain sind, Google jedoch nur 20.000 Seiten pro Tag crawlt, kann ein vollständiger Crawl viel Zeit in Anspruch nehmen.

screamingfrog.co.uk

Mit einer gut durchdachten Informations-Architektur lässt sich der Googlebot besser steuern als über die robots.txt-Datei. Schaffe einen logischen Pfad durch die Seiten, der für Nutzer und Suchmaschinen gleichermaßen Sinn ergibt.

Bei umfangreichen Webseiten empfiehlt es sich zudem, die eigenen Server-Logfiles zu analysieren, da diese bei Weitem aktueller sind als in der Search Console. Es bietet es sich an, bei Abweichungen von vorher definierten Metriken mit Alerts zu arbeiten, da die Anzahl der Einträge in Logs händisch nicht mehr verwaltbar ist.

Wenn man sich bisher noch keine Gedanken zur Auswertung der Server-Logfiles einer umfangreichen Webseite gemacht hat, kann es sich lohnen, mit einem ELK-Stack zu beginnen. Hierbei handelt es sich um eine Kombination aus Elastic Search, Logstash und Kibana, mit dem die Logfiles gesammelt, gespeichert und ausgewertet werden.

crawlo.com

Nicht alles, was die Logs sagen, ist richtig. Deshalb gilt es insbesondere darauf zu achten, welcher der wahre Googlebot ist und welcher nicht.

Eine weitere Möglichkeit: Den Googlebot durch einen externen Crawler zu simulieren, der über die Seite läuft. Schnell werden dann Probleme sichtbar, die Google möglicherweise vom Crawling abhalten oder einschränken.

Welche Strategien kann ich nutzen, um Millionen von Seiten mit internen Links zu versorgen?

Die interne Verlinkung ist besonders bei Webseiten mit vielen Unterseiten wichtig, um die Nutzer und natürlich auch den Googlebot durch die Webseite zu führen. Es gibt keine pauschale Lösung, wie man Hunderttausende oder Millionen von Seiten mit internen Links versorgen kann. Fest steht, dass es in dieser Großenordnung einer automatisierten Lösung bedarf.

Sind die eigenen Inhalte so aufgeteilt, dass sie zum Beispiel in eigene Silos aufgeteilt werden können? Oder macht es Sinn, die Navigation breiter, zum Beispiel mit Hilfe eines Mega-Menüs, zu gestalten?

Beide Varianten machen es auf verschiedenen Wegen möglich, eine große Anzahl an Seiten automatisiert mit internen Verlinkungen zu versorgen. In beiden Fällen ist es wichtig, klare strategische Ziele festzulegen.

Rise At Seven

Eine offensichtliche Strategie ist die Nutzung einer Breadcrumb-Navigation, sowie der Kopf-und Fußzeilen.

Bei der Entscheidung, welche Seiten am häufigsten intern verlinkt werden sollen, können auch die Analytics-Werte eine Entscheidungshilfe sein. Verlinke vorrangig die trafficstarken Seitentypen.

Zwei weitere hilfreiche Strategien sind interne Verlinkungen im „Wikipedia-Stil” sowie der automatischen Bereitstellung von Links zu ähnlichen und weiterführenden Seiten, zum Beispiel in der Sidebar eines Artikels.

Welche Stolpersteine tauchen häufig bei der technischen Umsetzung auf?

Die Umsetzung von Maßnahmenkatalogen stellt für Websites jeder Größe eine Herausforderung dar. Dies gilt umso mehr für umfangreiche Webseiten. Aus diesem Grund haben wir unsere Experten gebeten, von Stolpersteinen zu berichten, die sie häufig bei der technischen Umsetzung zu Gesicht bekommen.

Oft sind es fehlende technische Kapazitäten: Wenn nötige Ressourcen nicht für die IT-Abteilung eingeplant werden, kann das schnell dazu führen, dass Pläne nicht vollumfänglich umgesetzt werden (können) oder zumindest nicht im geplanten Zeitrahmen.

obi.de

Schließlich sollte man für jeden Seitentyp festlegen, welche SEO Maßnahmen wie funktionieren sollen. Damit macht man es nicht nur der IT leichter, sich schnell einen Überblick über die bereits umgesetzten Maßnahmen zu verschaffen, sondern auch sich selbst.

Zwei Klassiker, wenn es um Fehler bei der technischen Umsetzung geht, sind fehlende oder falsch gesetzte Tags, sei es die hreflang-Auszeichnung oder die eindeutige Festlegung einer kanonischen Version mittels Canonical-Tag.

Interessanterweise ist der am stärksten unterbewertete Punkt die Kommunikation: Hinter großen Webseiten stehen häufig große Organisationen mit vielen Beteiligten im Produktionsprozess. Das Sprichwort „Viele Köche verderben den Brei”, trifft es leider viel zu gut.

Ein gutes Hilfsmittel sind automatisierte Verfahren; zum Beispiel in der Form von Unit-Tests, um vor und nach jedem Release sicherzustellen, dass alles wie gewünscht funktioniert. Bei der Agilen Entwicklung haben sich SEO-Checkpoints als probates Mittel erwiesen – mögliche Hindernisse lassen sich so früh erkennen.

Wie verändern die Brand-Suchen einer starken Marke meine Keywordrecherche?

Wenn es sich bei einer großen Webseite um eine bekannte Marke handelt, können die darüber erzeugten Brand-Suchen interessante Aufschlüsse über die Webseite geben.

Obwohl sich unsere Experten einig sind, dass eine starke Marke die reguläre Keywordrecherche nicht beeinflusst, kann sich eine Auswertung der Brand-Suchen lohnen.

Denn hier lassen sich vor allem Aufschlüsse über die Inhalte der Seite beziehen, die von den Nutzern als markenspezifisch angesehen werden. Zudem haben große Unternehmen die Möglichkeit, über andere Kanäle, zum Beispiel TV-Werbung, Suchvolumen für neue Keywords zu erzeugen. Für diese Eigenkreationen hat man dann ein ganz anderes Marktumfeld geschaffen als für generische Suchanfragen.

firecask.com

Es kommt ganz darauf an, wie die Marke in der Öffentlichkeit wahrgenommen wird. Wenn die Wahrnehmung nicht durchgehend positiv ist, sollte bei der Keywordrecherche auch immer das Thema „Reputationsmanagement” berücksichtigt werden.

Wie kann ich die Zuteilung meines Keyword-Materials so organisieren, dass sich die verschiedenen Formate nicht gegenseitig kannibalisieren?

Mit großen Webseiten kommt häufig ein großes Aufgebot an möglichen Inhalten und Inhaltsformaten. Wie es möglich ist, die Verteilung der Inhalte auf verschiedene Formate wie Blog, Video, Ratgeber, genau so zu steuern, dass sich diese nicht gegenseitig kannibalisieren, ist eine zentrale Frage.

Bei der Zuteilung kann man den Nutzer-Intent zu Hilfe nehmen. Google zeigt bei Eingabe einer Suchphrase automatisch die Formate, die aktuell von den Nutzern präferiert werden. Skalierbar lässt sich dies über eine Auswertung der SERP-Snippets der gewünschten Keywords aufziehen. Dort lässt sich auswerten, zu welchen Anfragen beispielsweise Videos gut ranken.

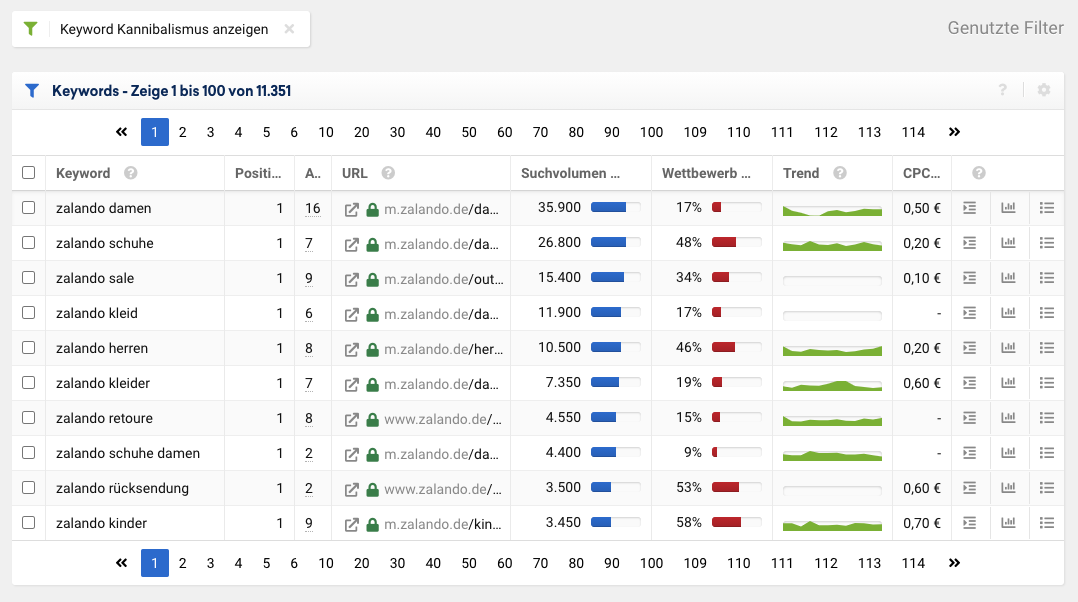

Um Kannibalisierung aufzudecken, kann man sich hilfreicher Tools bedienen. Sie spüren Unterseiten auf, die sich bei Keywords im Ranking abwechseln oder bei denen gar mehr als eine Unterseite in den Ergebnissen auftaucht. In diesen Fällen muss redaktionell entschieden werden, welche Unterseite für die jeweilige Suchanfrage das sinnvollere Ergebnis liefert.

safecont.com

Um Kannibalisierung zu vermeiden, sortieren wir unseren Content von Allgemein bis Spezifisch. Sollten bei einer Suche zwei Ergebnisse erscheinen, wird das allgemeinere immer vorgezogen.

Ein effizienter Schritt zur Vorbeugung von Kannibalisierung ist eine stringente und logisch aufgebaute Struktur in der Informations-Architektur der Seite. Ein klares Regelwerk, wann welche neue Seiten erstellt werden und wo diese in der Struktur angesiedelt werden, verhindert, dass sich ähnelnde Inhalte wahllos erstellt werden.

Wie kann ich Evergreen-Content skalierbar erstellen, erkennen und ausbauen?

Der große Vorteil am Internet besteht darin, dass Beiträge nicht, wie in Tages- oder Wochenzeitungen, immer wieder von neuem verdrängt werden und somit sehr viele fragmentierte Inhalte zu einem Themengebiet geschaffen werden.

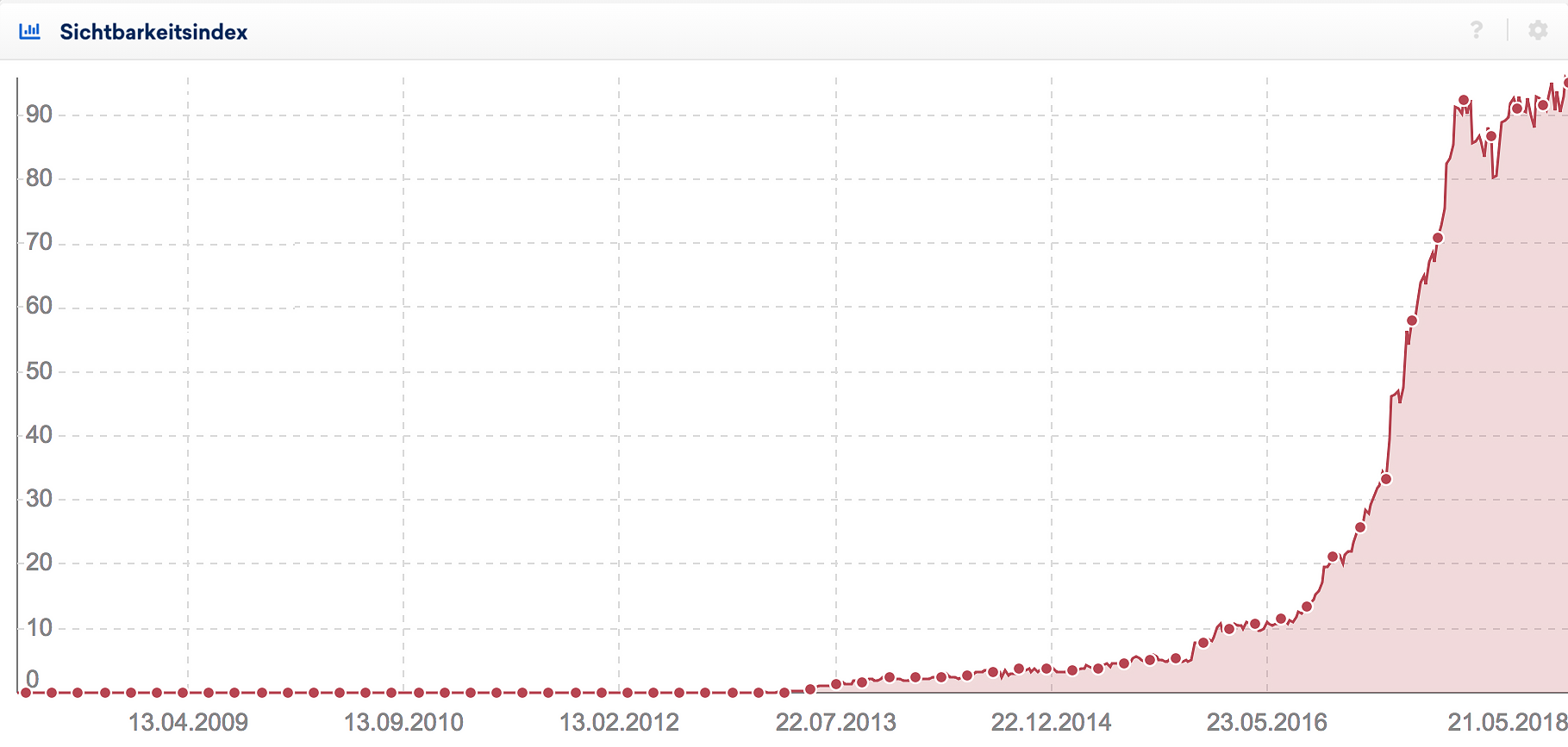

Online lassen sich einzelne URLs erstellen, auf denen Inhalte durchgehend verfügbar sind. Diese Evergreen-Inhalte haben sich als starke Traffic- und Vertrauenslieferanten erwiesen. Man sollte entsprechende Formate erkennen und ausbauen.

Zur Identifizierung des eigenen Evergreen-Contents bietet sich das eigene Webanalyse-Tool an. Welche Themengebiete konnten kontinuierlich oder saisonal über mehrere Jahre hinweg starke Traffikströme generieren? Zudem lassen sich Analysetools nutzen, um URLs zu finden, die für sehr viele Keywords in der Top 10 ranken.

Ihr müsst euch nicht nur auf die eigene Seite konzentrieren um Inhalte zu finden, die den Test der Zeit überstehen. Zusätzlich kann über eine Content-Gap-Analyse mit der Konkurrenz geschaut werden, für welche Inhalte dort Evergreen-Content erschaffen wurde.

Bei der Contenterstellung hilft ein klarer Prozess, der schon bei der Konzeption einer Seite prüft, ob diese zum Evergreen-Format taugt. Auch hier kann man gut mit Themen-Clustern arbeiten, um neue Beiträge aufzuspüren.

Egal, ob bei der Erstellung oder dem Ausbau, Contentproduktion ist immer ein redaktioneller Prozess und kann nicht maschinell ausgelagert werden. Eine Skalierbarkeit ist gegeben, kann erfahrungsgemäß aber nur über ein entsprechend großes Team realisiert werden.

Freiberuflicher SEO-Berater

Contentproduktion ist nur im Team skalierbar!

Was kann ich aus meiner internen Suche lernen?

Keine umfangreiche Website kommt ohne eine interne Suche aus. Die Spannbreite der Systeme, von Out-Of-The-Box-Lösungen bis hin zu Eigenkreationen, ist enorm und auch die Qualität der Suchen unterscheidet sich stark. Es gibt jedoch eine ganze Reihe an guten Argumenten für die interne Suche als wichtiges Hilfsmittel – in erster Linie für den Nutzer.

Das allein ist Grund genug, in die interne Suche zu investieren. Probleme in diesem Zusammenhang kommen leider häufig durch fehlende Zuständigkeit auf. Es sollte einen klaren Ansprechpartner im Unternehmen geben, der dediziert für die interne Suche verantwortlich ist.

manyminds.digital

Für die Besucher, die sich nicht zu einzelnen Kategorieseiten durchklicken möchten, ist die interne Suche eine wichtige Funktion.

Aus den Informationen der internen Suche können viele Abteilungen wichtige Erkenntnisse ziehen. So lassen sich Seiten finden, die stark frequentiert, jedoch in der Navigation nicht gut zu finden sind.

Besonders spannend: Was suchen und erwarten die eigenen Besucher von der Webseite. Eine Analyse aller Suchergebnisse, bei denen kein Ergebnis ausgeliefert werden konnte, gibt Aufschluss darüber bei welchen Suchanfragen die Seite die Nutzerintention nicht richtig befriedigen konnte.

Keinesfalls sollten die internen Such-Ergebnisseiten in den Google-Ergebnissen erscheinen. Google ist kein Freund von „SERPs-in-SERPs”.

Was bringen A/B-Tests?

Das Prüfen der eigenen Hypothesen hat sich besonders in der Conversion-Optimierung als guter Weg erwiesen. Entscheidungen werden nicht aus dem Bauch heraus getroffen, sondern auf Grundlage belastbarer Daten.

Zunächst unterscheiden wir zwischen A/B-Tests zur Überprüfung von Nutzerinteraktionen (Conversion-Optimierung) und A/B-Tests von SEO-Rankingfaktoren. A/B-Tests für Rankingfaktoren sind schwierig, da sich sehr viele der Faktoren nicht im Test ausschließen lassen. Jede Art von Nutzerinteraktion hingegen sollte unbedingt und so häufig wie nur möglich getestet werden.

Unidad Editorial

Wenn man nicht selbst testet, wie Google auf die Veränderungen der eigenen Seite reagiert, wird man diese Prozesse nie verstehen. Habe keine Angst vor Log-Analysen oder A/B-Tests, nur so kannst du besser werden.

Wenn es an die Umsetzung von Tests geht, sollte vor allem ein fester Ansprechpartner während des kompletten Tests festgelegt und verfügbar sein. Es hat sich gezeigt, dass Deployments vor dem Wochenende und Feiertagen häufig zu Problemen führen, die dann nicht direkt behoben werden können.

Viele Anbieter und Frameworks setzen auf JavaScript. A/B-Tests bergen daher ein hohes Risiko für die Funktionalität der eigenen Webseite. Entsprechend wichtig ist es, den Test gut zu monitoren, um Probleme frühzeitig erkennen zu können.

Idealerweise gibt eine Notbremse, die gezogen werden kann, um den Test zu stoppen und den Code auszubauen.

Um möglichen Duplicate-Content-Problemen beim Testen vorzubeugen, sollte die aktuelle Version A (Nullhypothese) immer als kanonische Version angegeben werden – Suchmaschinen können so, über eine Abfrage des User-Agents, auf diese Version A geschickt werden.

Welche Voraussetzungen muss meine Webseite mitbringen, damit eine Internationalisierung mit hreflang möglich wird?

Mit der hreflang-Auszeichnung hat Google eine Möglichkeit geschaffen, sprachlich verschiedene, aber inhaltlich zusammengehörende Unterseiten zu verbinden und diese Zugehörigkeit für Suchmaschinen verständlich zu machen. Zwar kommt hreflang mit relativ simplen Regeln aus, trotzdem lässt sich hier viel falsch machen.

Einen Blick in die Voraussetzungen für Googles Nutzung des hreflang-Attributs zu werfen, lohnt sich: Neben vielen möglichen technischen Stolpersteinen, kommt es auch häufig zu konzeptionellen Fehlern.

Die beste Voraussetzung ist ein internes System, das die Zugehörigkeit der Inhalte zwischen den Sprachen kennt. Hierzu gehören URLs aber auch Artikelnummern – besonders wenn es je verschiedene für unterschiedliche Länder gibt.

bloofusion.de

Grundvoraussetzung für korrekte hreflang-Tags ist eine identische Struktur der verschiedenen Länderseiten.

Es gibt viele Möglichkeiten mit Behelfsgerüsten eine Seite so hinzubiegen, damit hreflang funktioniert. Jedoch ist nur eine saubere technische Umsetzung in der Lage, spätere Veränderungen sowie neue Seiten und Sprachen ohne massiven Mehraufwand zu erschließen.

Wie behalte ich den Überblick über das komplette Projekt und wann lohnt sich eine Auswertung auf Ebene einzelner Keywords?

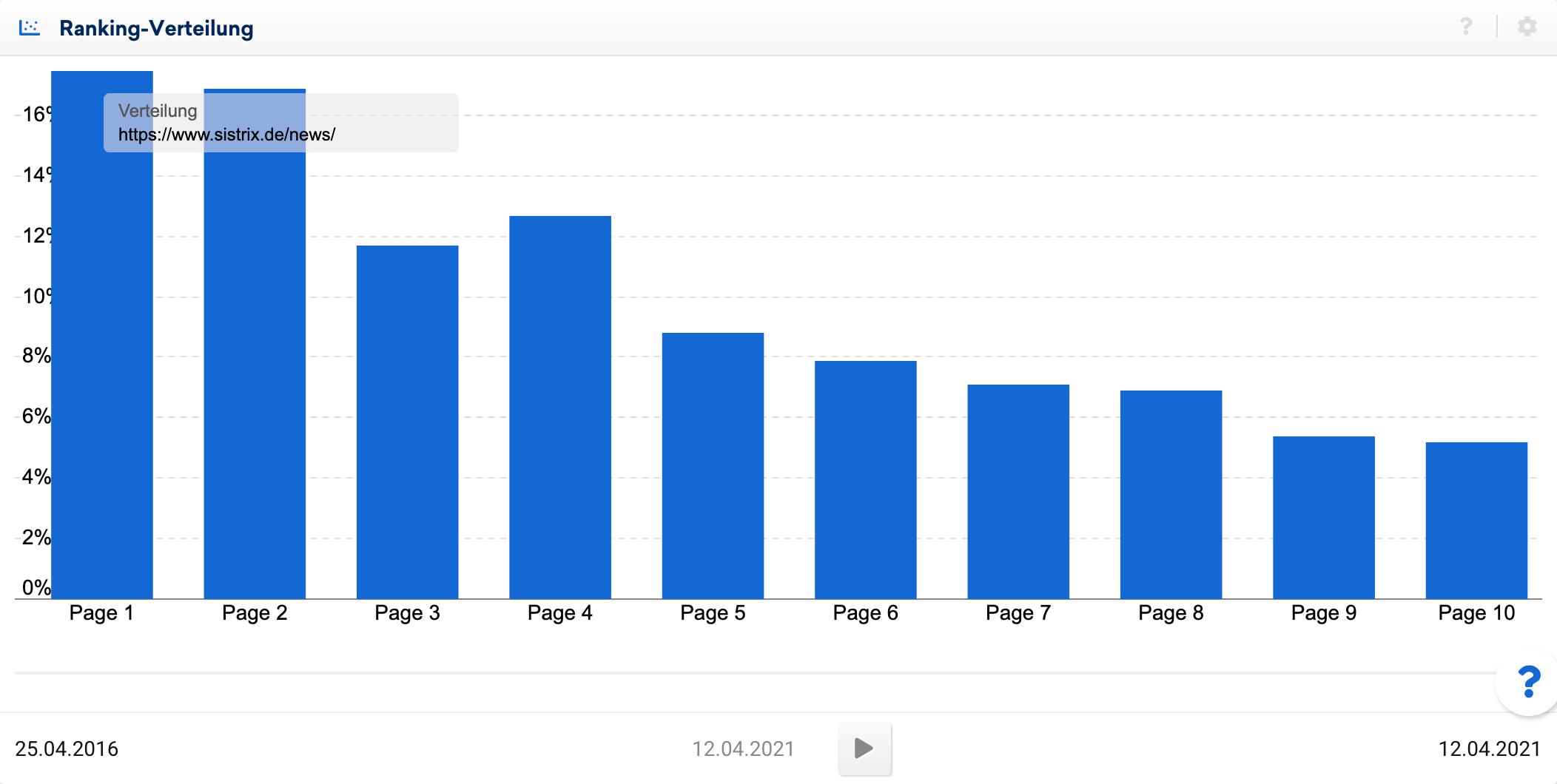

Schon bei wenigen zehntausend Seiten ist es nicht mehr praktikabel, Auswertungen für jede einzelne Unterseite zu fahren.

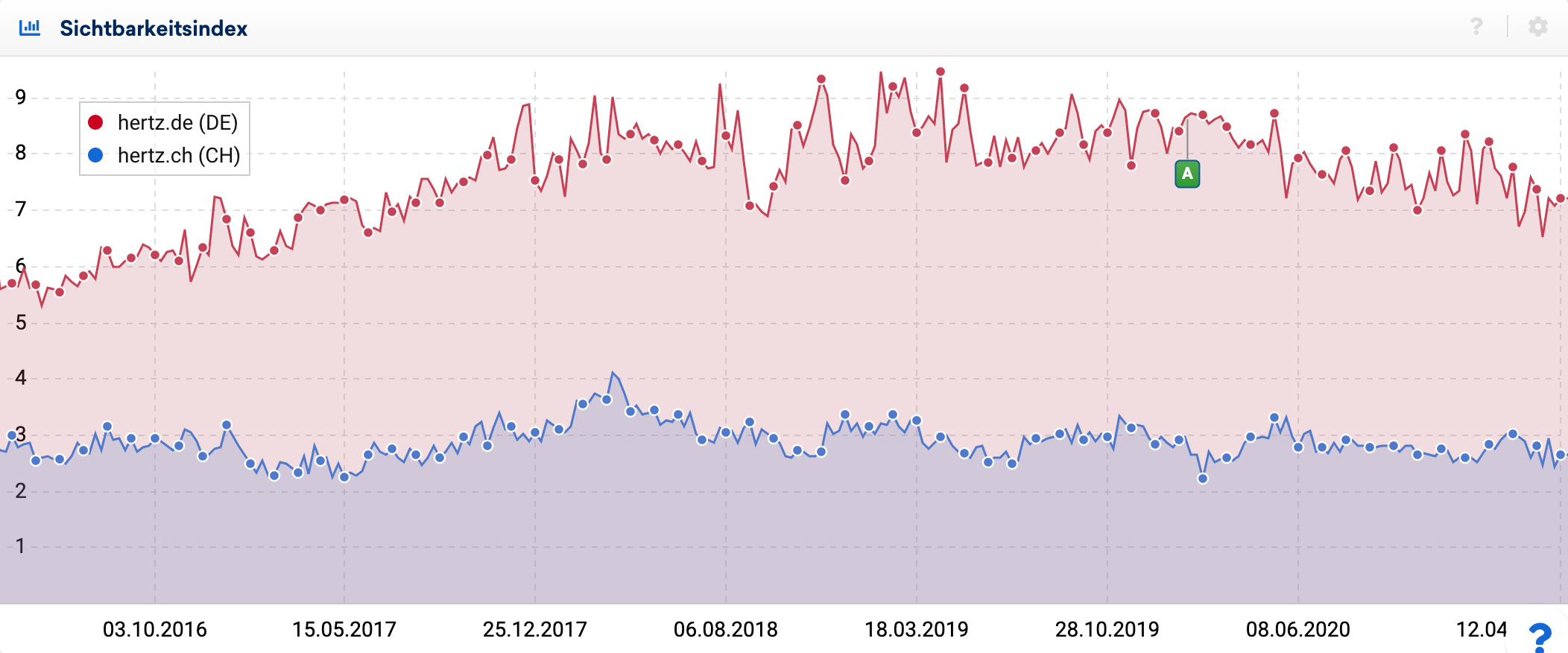

Bei umfangreichen Webseiten können automatische Alerts auf die internen Auswertungen eingerichtet werden, die bei einer Abweichung von der Norm ausschlagen. Sinn der Übung ist es nicht, bei jedem Ausschlag panisch zu reagieren, sondern frühzeitig Trends zu erkennen.

FunnelPunk.com

Um den Erfolg eines großen Projekts möglichst effizient zu überblicken, empfiehlt sich das Monitoring ganzer Keywordgruppen – für jede Landingpage, Unter- oder Produktseiten.

Diese Trends, egal ob negativ oder positiv, können dann eingehend analysiert und Ursachen identifiziert werden.

Für generelle Auswirkungen können Indezes sehr hilfreich sein, besonders wenn es darum geht mögliche Google-Updates anhand einer breiten Masse an Beispielen zu bewerten. Zudem bietet es sich an ein eigenes Keyword-Set zu überwachen, anhand dessen Bereiche, Themengebiete oder ganze Nischen abgedeckt und näher betrachtet werden können.