Wie Robots-Meta-Tags dienen X-Robots-Tags dazu, das Crawling und die Indexierung von Seiten zu steuern. Dabei weisen sie einige entscheidenden Unterschiede auf: X-Robots-Tags werden in den Response-Headern des HTTP-Protokolls (nicht in HTML) bereitgestellt und sind daher nicht auf HTML-Dateien beschränkt.

Du willst, dass Seiten nicht in den Suchergebnissen von Suchmaschinen auftauchen? Sicherstellen kannst du das mit Robots-Meta-Tags. Aber was machst du, wenn du eine Seite indexieren lassen willst, aber nicht das Bild darauf? In diesem Fall – und einigen anderen Fällen – bietet sich der X-Robots-Tag an.

So verwendest du den X-Robots-Tag

Beim X-Robots-Tag handelt es sich um einen HTTP-Header. Eine Antwort mit einem X-Robots-Tag kann zum Beispiel folgendermaßen aussehen:

HTTP/1.1 200 OK

Date: Wed, 13 May 2020 19:30:25 GMT

(…)

X-Robots-Tag: noindex

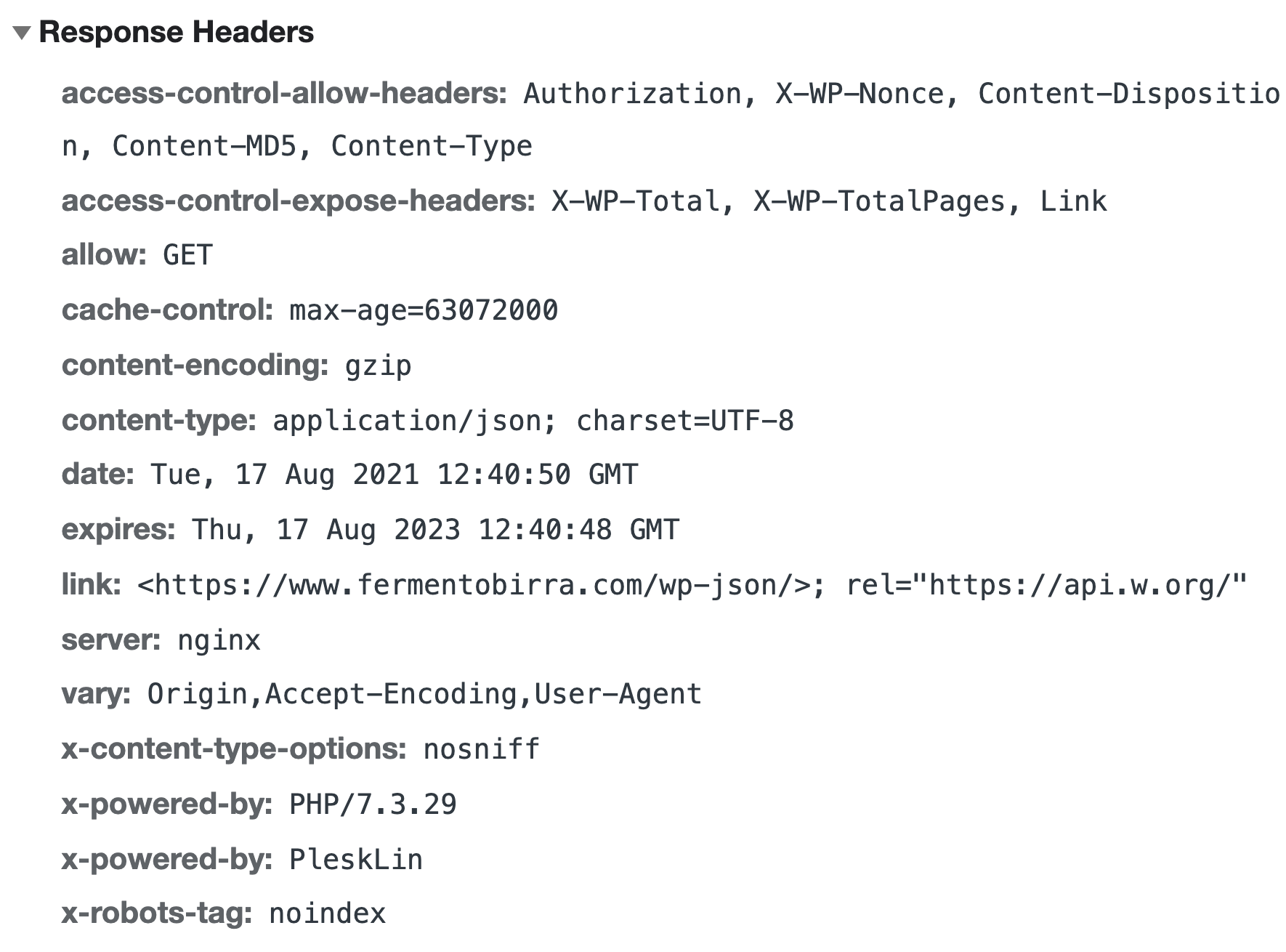

(…)Dies ist in den Chrome-Devtools bei der Anzeige des HTTP-Response-Headers zu sehen. Hier ein Beispiel mit dem X-Robots-Tag am unteren Rand:

Wie bei Robots-Meta-Tags hast du die Möglichkeit, mehrere Header miteinander zu kombinieren. Die Werte sind laut Google in beiden Fällen dieselben. Allerdings hängt die genaue Konfiguration vom Webserver ab sowie davon, was nicht indexiert werden soll.

Beim bekanntesten Servertyp Apache verwendest du am besten httpd.conf- und .htaccess-Dateien, um X-Robots-Tags festzulegen. Willst du zum Beispiel alle PNG- und GIF-Dateien auf einer Seite von der Indexierung fernhalten, gibst du in Apache folgenden Code in die .htaccess– oder httpd.conf-Stammdatei der Webseite ein:

<Files ~ "\.(png|gif)$">

Header set X-Robots-Tag "noindex"

</Files>Mit den Files und FilesMatch-Optionen können reguläre Ausdrücke verwendet werden, um eine große Anzahl von Dateien in einer einzigen Code-Zeile abzugleichen.

Wann ein X-Robots-Tag die richtige Wahl ist

X-Robots-Tags sollten nur fortgeschrittene Nutzer verwenden, da Fehler schwerwiegende Folgen für deine Webseiten haben können. Deshalb empfehlen wir dir auch, vorher unbedingt ein Backup durchzuführen. So bist du auf der sicheren Seite.

Warum solltest du X-Robots-Tags dann überhaupt verwenden? Speziell in folgenden Situationen sind sie trotz der komplizierten Anwendung die richtige Wahl:

- Du willst gezielt Anweisungen für Nicht-HMTL-Dateien wie Bilder oder PDFs geben.

- Du möchtest größere Mengen von Seiten mit bestimmten Parametern oder zum Beispiel eine komplette Subdomain deindexieren.

Im ersten Fall sind X-Robots-Tags die einzige Möglichkeit, im zweiten sparen sie Zeit und Aufwand gegenüber dem mühseligen einzelnen Setzen von Robots-Meta-Tags.

SISTRIX kostenlos testen

Beginne noch heute, mit SISTRIX deine Rankings zu verbessern.

- Kostenloser Testaccount für 14 Tage

- Unverbindlich, keine Kündigung notwendig

- Persönliches Onboarding durch Experten