Webcrawler wie der Googlebot, aber auch unser SISTRIX Onpage-Crawler haben sich in den letzten Jahren deutlich weiterentwickelt. Wurde früher nur HTML ausgewertet, sind es mittlerweile vollständige Browser, die Javascript und andere Ressourcen ausführen.

Dabei ist es wichtig, dass individuelle Daten, die in einem Rendering-Prozess vorliegen, nicht von anderen Rendering-Prozessen gelesen oder gar verändert werden können. Das betrifft natürlich und naheliegend Inhalte aus den bekannten Cookies, aber mittlerweile auch viele weitere Datenstorage-Möglichkeiten im Browser.

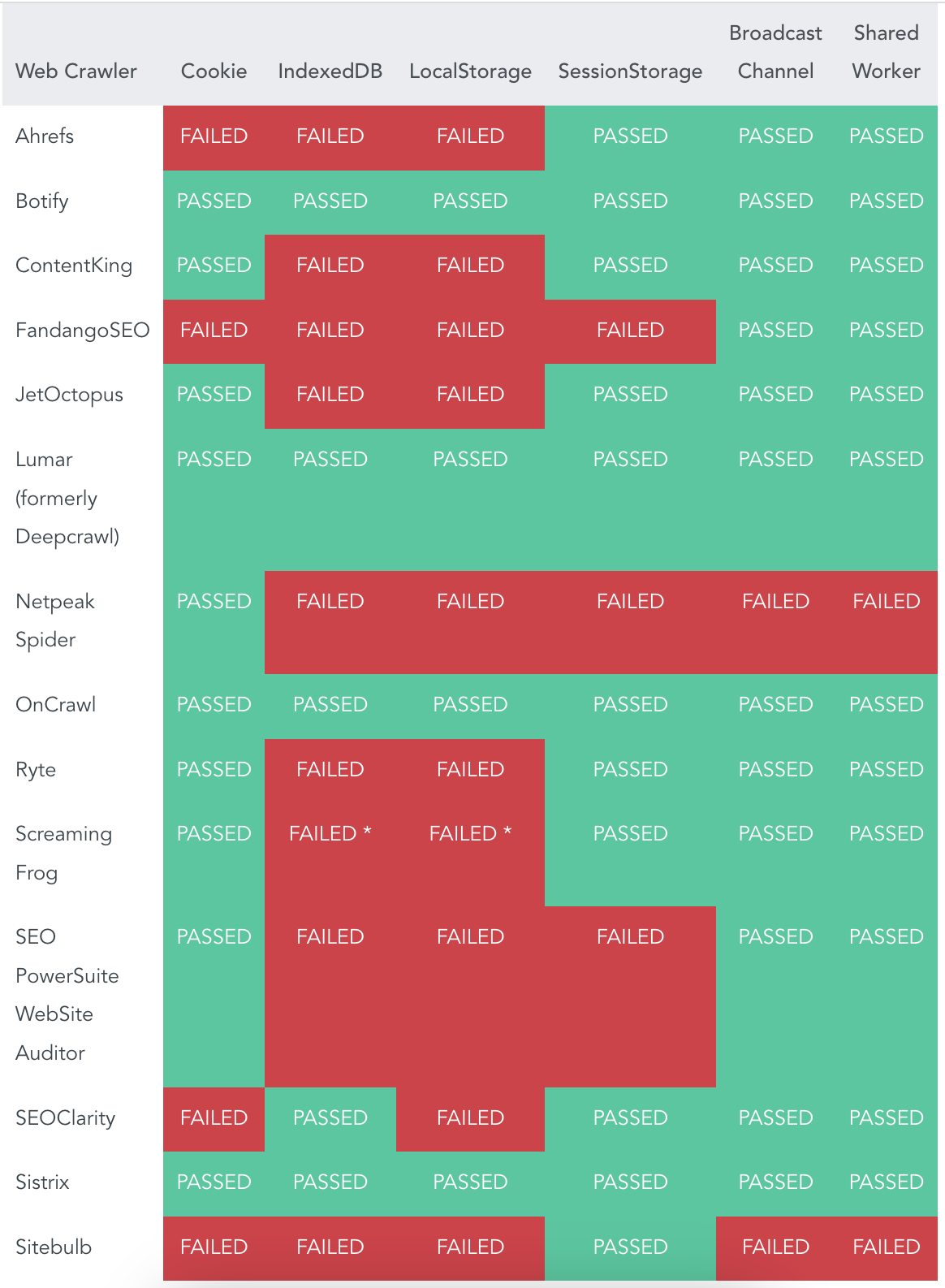

Merj, eine Consulting-Firma für Digitalthemen, hat nun in einer umfangreichen Studie untersucht, wie gut das bei den Onpage-Crawlern der gängigen SEO-Tools funktioniert. Dabei wurden sechs unterschiedliche Storage-Optionen über die Crawler von 14 Anbietern ausgewertet. Die Ergebnisse im Überblick:

Ich freue mich sehr, dass unser Onpage-Crawler einer von vier Crawlern ist, der alle Tests mit Bravour gemeistert hat. Dabei sind wir der einzige Anbieter einer umfassenden SEO-Suite-Lösung, die das geschafft haben.