In den letzten Wochen hat Google Änderungen an der Zusammenstellung der Ergebnislisten vorgenommen. Ich habe auf Basis unserer Daten versucht rauszufinden, was Google da eigentlich genau macht und welche Auswirkungen es auf Suchende als auch auf SEOs hat. Vorneweg noch kurz der Hinweis, dass Google uns aktuell mit Pseudo-Transparenz überhäuft: monatlich werden lange Listen irgendwelcher Algorithmus-Anpassungen veröffentlich, der reale Einfluss ist in der Regel marginal. So wurde unter dem Google-Codenamen „Venice“ eine Änderung angekündigt, die Häufigkeit und Platzierung von Local-Universal-Boxen verändert. Als Folge wird seit Wochen in der SEO-Branche von einem „Venice“-Update geredet, das Einfluss auf die organischen (!) SERPs habe. Abgesehen davon, dass Google in der Tat an der lokalen Auslieferung mancher Keywords spielt, täte es der Branche gut, analytische Trennschärfe vor marktschreierisches Gehabe zu stellen und Google nicht noch in der Verbreitung maximaler Verwirrung zu unterstützen.

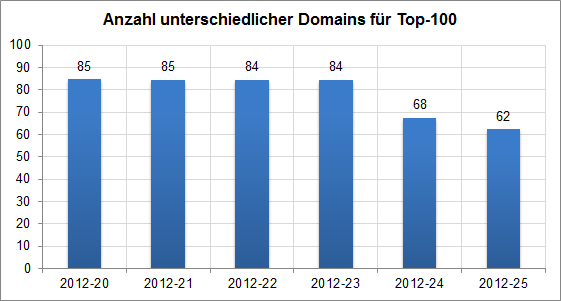

Früher galt bei Google das Gesetz, dass maximal 2 Treffer eines Hostnamens in einer Ergebnisseite auftauchen. Google hat bereits vor Jahren eine Ausnahme davon gemacht und lässt seit langer Zeit bei sehr starken Markensuchen auch mehr Treffer von einer Domain zu – hier ergibt das in der Regel für den Suchenden auch durchaus Sinn. Seit rund 3 Wochen weicht Google dieses Verhalten allerdings zunehmend auf. Zur Veranschaulichung hier die durchschnittliche Anzahl unterschiedlicher Domains in den Top-100 Treffern der von uns untersuchten Keywords:

Deutlich zu sehen, dass sich die durchschnittliche Anzahl von Domains in den Top-100-Treffern während der letzten 3 Wochen von 84 Domains auf nur noch 62 Domains reduziert hat – immerhin mehr als ein Viertel weniger. Um dem etwas genauer auf den Grund zu gehen, habe ich mir diese Auswertung mit den beiden entscheidenden Daten (diese Woche, vor 3 Wochen) noch für unterschiedliche Ergebnis-Seiten angesehen:

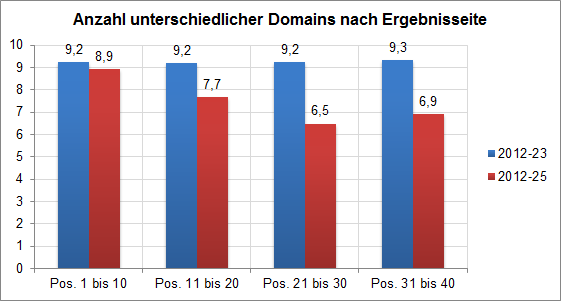

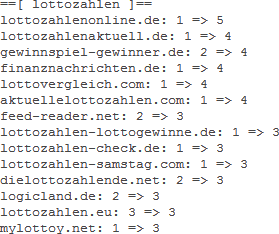

Hier ist schön nachzuvollziehen, dass es auf der wichtigen ersten Trefferseite kaum Veränderungen gab. Die größte Verschiebung gab es auf der 3. Ergebnisseite – hier werden rund 30 Prozent weniger unterschiedliche Domains gezeigt als vor dem Update während auf der erste Seite nur 3 Prozent weniger Domains gelistet sind. Um die Veränderungen besser nachvollziehen zu können und den Blick vom Gesamten auf Details zu lenken, habe ich mir 5 Keywords mit größerer Veränderung abgezeigt. Bei der Suche nach ‚Lottozahlen‘ waren vor 3 Wochen noch 89 unterschiedliche Domains in den Top-100, jetzt sind es gerade mal 50. Dabei ist es jetzt allerdings nicht so, dass große und etablierte „offizielle“ Verbreiter der Daten gewonnen haben, sondern zahlreiche Domains, von denen man das aus Qualitätsgründen nicht unbedingt vermutet hätte. Vergleichbare Daten gibt es zu Keywords wie „Reinigungskraft“, „Vorwahl“, „Virenschutz“ oder auch „Hauptstadtflughafen“ (wenn er denn mal fertig wird).

Hier ist schön nachzuvollziehen, dass es auf der wichtigen ersten Trefferseite kaum Veränderungen gab. Die größte Verschiebung gab es auf der 3. Ergebnisseite – hier werden rund 30 Prozent weniger unterschiedliche Domains gezeigt als vor dem Update während auf der erste Seite nur 3 Prozent weniger Domains gelistet sind. Um die Veränderungen besser nachvollziehen zu können und den Blick vom Gesamten auf Details zu lenken, habe ich mir 5 Keywords mit größerer Veränderung abgezeigt. Bei der Suche nach ‚Lottozahlen‘ waren vor 3 Wochen noch 89 unterschiedliche Domains in den Top-100, jetzt sind es gerade mal 50. Dabei ist es jetzt allerdings nicht so, dass große und etablierte „offizielle“ Verbreiter der Daten gewonnen haben, sondern zahlreiche Domains, von denen man das aus Qualitätsgründen nicht unbedingt vermutet hätte. Vergleichbare Daten gibt es zu Keywords wie „Reinigungskraft“, „Vorwahl“, „Virenschutz“ oder auch „Hauptstadtflughafen“ (wenn er denn mal fertig wird).

In der Bewertung der Algorithmus-Anpassung sind die direkten Folgen überschaubar – dadurch, dass es auf der ersten Seite nahezu keine Änderungen gab, dürften Auswirkungen auf den Traffic eher gering sein. Auf der anderen Seite trifft die Anpassung gerade Suchende, die in ein Thema tiefer einsteigen möchten und mit den ersten Treffern nicht zufrieden sind. Diesen hat Google in der Vergangenheit teils deutlich mehr Auswahl an unterschiedlichen Inhalten angeboten. Diese ist jetzt häufig nicht mehr vorhanden und das Blickfeld des Informationensuchenden engt sich damit ein. Gerade als Quasi-Monopolist in einer Rolle als Gatekeeper des Internets, der unter scharfer Beobachtung diverser Kommissionen und Ämter steht, ist das vielleicht kein so ganz überlegter Schachzug gewesen.