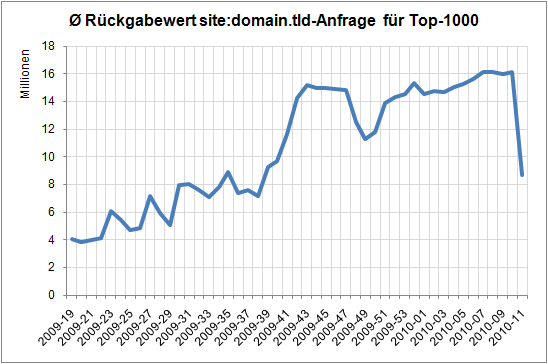

Seit dem Wochenende sorgt Google bei den Rückgabewerten der site:domain.tld-Abfrage für Verwirrung: sie liegen bei fast allen größeren Seiten auf einem deutlich niedrigeren Niveau im Vergleich zu den Werten der Vorwoche. So hat Wikipedia.org 72% verloren, Ebay.de rund 90% und Amazon.de laut der Daten gar 94% weniger Seiten im Index. Hier der Verlauf der durchschnittlichen Seiten im Googleindex der Top-1000-Domains laut SISTRIX Sichtbarkeitsindex in den letzten 12 Monaten:

Schön zu sehen, dass sich der durchschnittliche Wert im letzten Jahr deutlich gesteigert hat, sich in dieser Woche aber von 16,1 auf 8,6 Millionen fast halbiert hat. Über die Hintergründe kann man nur spekulieren. Wer für Verschwörungstheorien offen ist, dem könnte etwas wie „Caffeine, erster und zweiter Index“ weiterhelfen … wir werden sehen, wie sich das entwickelt. Update: auch Eric hat sich heute zu dem Thema Gedanken gemacht: Dramatisch fallende Seitenzahlen im Google-Index