Wenn eine Suchmaschine Anpassungen an ihren Ranking-, Analyse- oder Crawling-Algorithmen vornimmt, die im Ergebnis einen erheblichen Anteil am Gesamtvolumen aller Anfragen betrifft, fragt man sich doch gelegentlich: „Woher wollen die eigentlich wissen, was relevant ist?“ Nun, die kurze Antwort darauf lautet: „Sie wissen es selbst nicht!“

Sie haben in vielen Fällen zwar jede Menge guter Indizien, aber ich will mal versuchen anhand eines Beispiels zu zeigen, dass die Analyse von systemimmanenten Daten keineswegs „allwissend“ macht. Außerdem werde ich versuchen zu veranschaulichen, wie man eine der von Suchmaschinen verwendeten Relevanz-Analysen nutzen kann, um die Relevanz der eigenen Seiten zu messen.

Sehen wir uns zunächst die am häufigsten eingesetzten Analysemethoden an, so lassen sich diese grob in zwei Gruppen unterteilen.

- Gruppe 1 umfasst alle Methoden, die systemimmanente Metriken, wie Clickstream-Daten, CTRs, Verweildauer, semantische Analysen, Linkstrukturen on und off Site etc. erfassen und bewerten.

- Gruppe 2 umfasst alle Methoden, die extern gesammelte Daten (z.B. Eyetracking, Online-Panels, User-Testing oder Focus-Gruppen) erfassen und bewerten.

Ich möchte an dieser Stelle den Bereich User-Testing näher untersuchen. Jetzt denken sicher einige: Nicht skalierbar! Viel zu teuer! Ich bin da ganz anderer Meinung – und die Suchmaschinen teilen diese.

Ein klassisches Beispiel für Relevanz, die sich nur sehr eingeschränkt mit Metriken wie CTR, Verweildauer, Ladezeit etc. messen lässt, ist die von speziellen Einblendungen in den SERPS (Search Engine Result Pages). Sieht man sich etwa die Ergebnisse für Suchanfragen nach Börsenkursen wie MSFT, GOOG, YHOO an, so bieten alle Player heute die wichtigsten Kennzahlen direkt auf der Seite an. Das hat zur Folge, dass der Nutzer nicht mehr messbar mit der Einblendung interagiert.

Finanz und Wetter Einblendungen in den SERPS 2012 (Google, Bing, Yahoo!)

„Lies, damned lies, and statistics“

Es kam in meiner Zeit als Search Product Manager durchaus vor, dass ein Engineer mir aus heiterem Himmel mitteilte, dass die Performance der Direkteinblendungen für Aktien, Wetter, Horoskope etc. zu schlecht sei und diese daher zeitnah abgeschaltet werden. Ich vermute, dass so etwas in einem wichtigen Markt wie den USA nicht so schnell passieren dürfte, aber wenn ein indischer Engineer auf eine Analyse von 4.000 CTR-Statistiken blickt und ein paar Features unterhalb des CTR-Minimums fallen, ist diese Herangehensweise aus seiner Sicht wahrscheinlich valide.

Tritt der Fall ein, dass die Analyse der im System vorhandenen Daten als ureigene Herangehensweise von Suchmaschinen keine befriedigende Antwort liefert, wird häufig auf das User-Testing gesetzt.

Viele Leser dürften von der Tatsache überrascht sein, dass Suchmaschinen diese Methode in vergleichsweise hoher Frequenz auch zum Analysieren ihrer organischen SERPS sowie für die Ergebnisseiten der News-, Bilder- oder der Lokalen Suche einsetzen. Die Resultate dieser Analysen werden auch sehr ernst genommen, und es gehört schon lange zum Standard, dass solche Metriken zu den Release-Kriterien von Suchmaschinen-Features zählen. Wird der angestrebte Wert nicht erreicht, wird das neue Feature nicht gelauncht.

Wie läuft ein solcher User-Test ab?

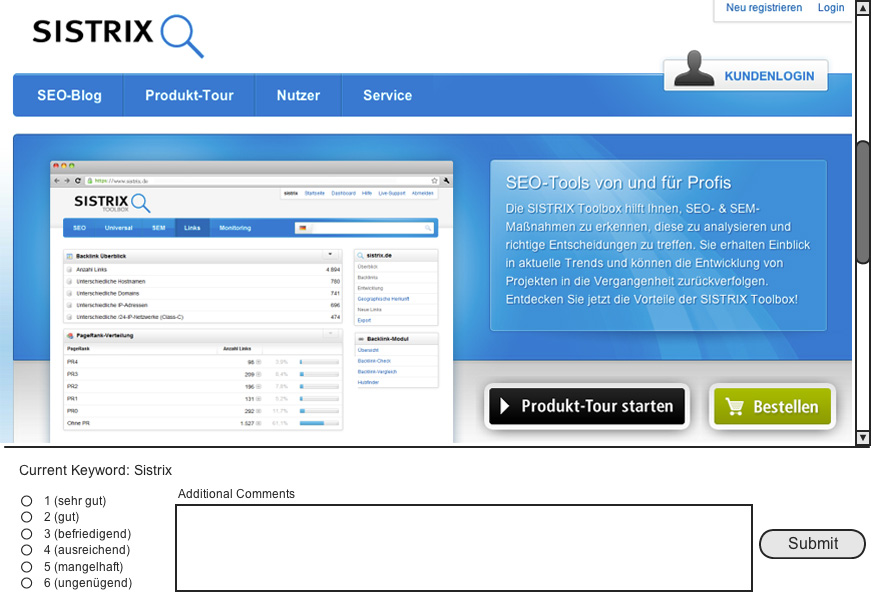

Beispielhaft und vereinfacht gesagt, heuert man eine Gruppe von Editoren/Testern an, die an einem Rechner jeweils einen Suchbegriff „sehen“ und dazu passend die entsprechende Webseite, die zu dem Term auf Platz X steht. Der Tester beurteilt die Qualität der Seite in Bezug auf den Suchbegriff anhand einer einfachen Bewertung, vergleichbar etwa mit Schulnoten:

Exemplarische Darstellung der Testumgebung aus der Sicht des Raters

1 (sehr gut) – wenn die Leistung den Anforderungen in besonderem Maße entspricht.

2 (gut) – wenn die Leistung den Anforderungen voll entspricht.

3 (befriedigend) – wenn die Leistung im Allgemeinen den Anforderungen entspricht.

…

(Zitiert nach: http://de.wikipedia.org/wiki/Schulnote)

Um sicher zu stellen, dass ein Tester die Ergebnisse nicht durch eine „falsche“ Einschätzung/Bewertung negativ beeinflusst, werden die gleichen Queries meist von mehreren Testern bewertet. In die Schlussberechnung fließen dann lediglich Ratings ein, die von mehreren Testern identisch oder fast identisch bewertet worden sind.

Am Ende der Berechnung steht dann ein Wert R, der die relative Relevanz zum Zeitpunkt X beschreibt. Anhand dieser Werte und der im Verlauf der Zeit entstehenden Historie lassen sich schließlich Trends ablesen. Es ist durchaus üblich, dass bei derartigen Messungen die Produkte der Mitbewerber in identischer Art mit getestet werden, um einen direkten Vergleich zuzulassen.

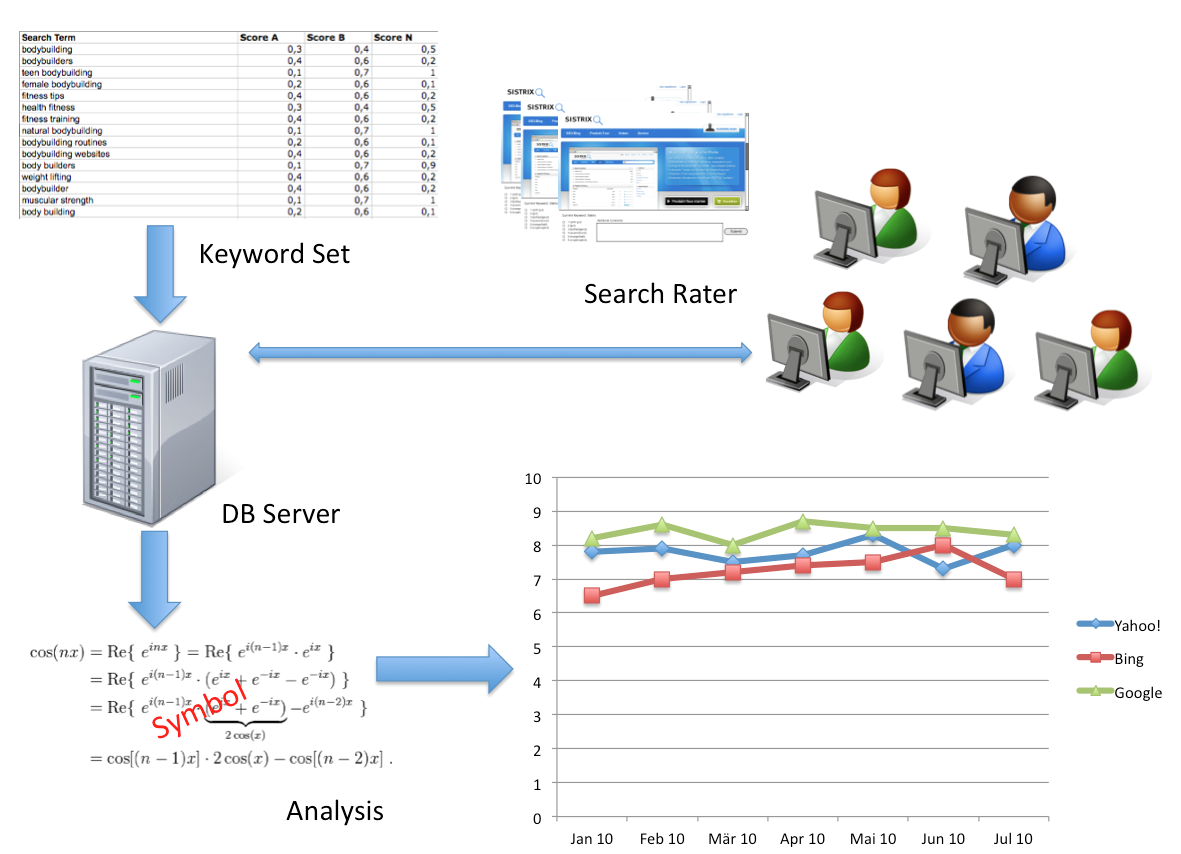

Schematische Beschreibung einer Testumgebung/Prozesse

Natürlich stößt diese Methode auch an Grenzen, denn sie ist einerseits sehr kostspielig, und birgt andererseits gewisse Risiken. Besonders bei der Bewertung im Long-Tail liegt die Vermutung nahe, dass ähnlich wie beim Publikumsjoker aus der TV-Sendung Wer-Wird-Millionär die Regel gilt: Toller Joker bei einfachen Fragen = Head Queries, mit Vorsicht zu genießen bei Fragen ab 64.000 Euro = Tail Queries.

Ähnlich wie bei dem beschriebenen Ranking durch Tester sollen die WWM-Kandidaten nur dann abstimmen, wenn sie sich ihrer Sache sicher sind. Die Ergebnisse in der Show zeigen aber, dass – freundlich ausgedrückt – einige Kandidaten so ihre Schwierigkeiten beim Einschätzen des eigenen Wissens haben.

Keyword Set-Auswahl – oder: Auch als beste Suchmaschine für Bürsten- und Pinselmacher kann man kein Geld verdienen.

Thematisch sind ja gerade Web-Suchanfragen sehr divers, darum ist es umso wichtiger, entsprechende Sorgfalt bei der Erstellung der Keyword-Sets für Relevanz Analysen walten zu lassen.

Es dürfte niemanden überraschen, dass für derartige Benchmarks nicht einfach beliebig zusammengestellte Suchbegriffe verwendet werden. Um ein aussagekräftiges Ergebnis zu erhalten, ist es notwendig, sowohl genügend Head- als auch Tail-Queries im Set zu haben. Außerdem werden die Suchbegriffe mit zusätzlichen Scores versehen, um deren Wert für den Test besser bestimmen zu können.

So dürfte zum Bespiel jedem einleuchten, dass die Keywords für Bürsten- und Pinselmacher als Unterkategorie der Lokalen Suche einen deutlich niedrigeren Score erhalten als Keywords für die Unterkategorie Restaurants. Denn dadurch wird der Tatsache Sorge getragen, dass nicht alle Bereiche gleich „wichtig“ also gut monetarisierbar, imageträchtig oder relevant für die Product Roadmap sind. Da Zeit und Budget immer begrenzt sind, helfen diese Scores dabei, sicherzustellen, dass man vor allem dort investiert, wo der ROI am höchsten ist.

Eine weitere Herausforderung im Umgang mit den Query-Sets ist der ewige Balanceakt zwischen Vergleichbarkeit von Daten und „Up-To-Date-Ness“. Auf der einen Seite sollte das Query-Set, mit dem die „Nullmessung“ vorgenommen wurde, nicht verändert werden, um Gewinne/Verluste möglichst exakt messen zu können. Ist ein Query-Set aber zu alt, hat das in der Regel eine negative Auswirkung auf die Messung. Wäre in meinem Set z. B. die Query „Bundeskanzler Deutschland“ so ist das perfekte Ergebnis am 21. November 2005 ein anderes als das am 22. November 2005, dem Tag, an dem Angela Merkel den Job übernahm und zur ersten Bundeskanzlerin gewählt wurde.

Was springt jetzt dabei für mich raus? „Show me the Money!“

Nach diesem Ausflug kehre ich jetzt zurück zur Kernfrage aller derer, die den SISTRIX Blog lesen: Wie hilft mir das alles in meinem Job als SEO, Webmaster, Produktverantwortlicher oder Engineer?

Im einfachsten Setup sollte man sich seinen Postboten schnappen und ihm 50 Euro für 20 Minuten seiner Zeit bieten. Ihr nennt ihm einen Suchbegriff, setzt ihn vor eure Landing Page und befragt ihn dazu.

Zugegeben, das kann eher „creepy“ rüberkommen, aber wer nicht wagt der nicht gewinnt. Und Ihr versteht schon, wie ich das meine.

Denjenigen unter euch, die über deutlich mehr als 50 Euro Budget verfügen, empfehle ich, einen Teil Ihres Geldes künftig bei einem Marktforschungsunternehmen auszugeben, um der Frage nach der Relevanz auf die Schliche zu kommen.

Unabhängig vom Setup verspreche ich, ihr lernt dabei mehr über eben jene Relevanz, als bei der Lektüre des nächsten Social Media Ranking Correlation Posts.

Hier noch ein Tipp für all diejenigen, die nicht in einem großen Unternehmen mit eigenen Testlabors arbeiten. Findet ein Marktforschungsunternehmen in eurer Nähe und lasst euch dort in deren Datenbank für Tests, Fokusgruppen etc. aufnehmen.

Ich mache das selbst mindestens einmal im Jahr und habe dabei jedes Mal spannende Dinge gelernt. Quasi eine Weiterbildung, die nicht nur kostenlos ist, sondern meist eine kleine Entlohnung mit sich bringt – und das bei stets leckerer Verpflegung und fast immer in gut klimatisierten Räumen.