Der fünfte SEO Day im Müngersdorfer Rhein-Energie-Stadion in Köln war ein voller Erfolg: 40 Referenten haben in 48 Vorträgen den rund 800 Teilnehmern geballtes SEO Know-How vermittelt. Im Vorfeld fanden die Expert Workshops und der ExpertDAY statt. In den Workshops gaben Bastian Grimm mit Linkbulding, Nicolas Sacotte mit Content Marketing, Christian Tembrink mit YouTube Online Marketing, Stephan Czysch mit Shop-SEO und Pablo Endres mit Informationen zu Web Security ihren Teilnehmern interessante Tipps und Hintergrundinformationen mit auf den Weg. Über den ExpertDAY darf, wie auch im Jahr zuvor, nicht berichtet werden.

Auch dieses Jahr waren wir beim SEO DAY wieder vor Ort und teilen mit Euch unsere Impressionen, sodass alle diejenigen, die kein Ticket ergattern konnten, mit aktuellem Wissen versorgt werden. Und all jene, die vor Ort waren, aber nicht alle Panels besuchen konnten, können hier die Erkenntnisse aus den verpassten Vorträgen nachlesen. Dieses Jahr waren die vier Vortragsräume nach Kategorien eingeteilt: Einsteiger, Expert I und Expert II, sowie für die Entwickler die SEOCodeDay-Vorträge.

- Bastian Grimm: Becoming the world's best crawled domain: On-Page SEO Extreme

- Jens Fauldrath: SEO Maintenance – SEO als Prozess verstehen

- Markus Klöschen: Content Marketing: Vom leeren Blog zum Zitat in der FAZ

- René Dhemant: Website-Relaunch – eine unendliche SEO-Geschichte

- Christian Solmecke: SEO & Recht: Die größten Abmahngefahren für Suchmaschinenoptimierer

- Johannes Beus: Google Search Console – Was zeigen uns Googles Rankingdaten?

- Kaspar Szymanski: Penalty Recovery – Tipps vom Ex-Googler

- Jakob Holterhöfer: Developing for PageSpeed

- Malte Landwehr: Häufige SEO-Fehler

- SuperPanel

- Street View im Rhein-Energie-Stadion: Bewege Dich durch die Räumlichkeiten des SEO DAY 2015

- Fazit und Rückblick

Bastian Grimm:

Becoming the world’s best crawled domain: On-Page SEO Extreme

Im ersten Expert-Panel des Tages beschäftigte sich Bastian Grimm, der Vice President Organic Search bei der Peak Ace AG, mit der Crawl-Budget- und Crawl-Rate-Optimierung. Im Speziellen zeigte er, wie man das, der Domain von Google zur Verfügung stehende, Crawl-Budget optimal zu den eigenen Gunsten steuern kann.

Ziele der Crawl-Rate-Optimierung und Crawl-Buget-Optimierung:

1. Ein möglichst vollständiger Crawl der Domain in akzeptabler Zeit

2. Schnelles Bemerken von Änderungen an bestehenden Inhalten und damit möglichst zeitnahes Aktualisieren der jeweiligen Inhalte im Index

3. Schnelles Auffinden von neuen Inhalten / URLs auf einer Domain, so dass selbige schnellstmöglich auch via Google auffindbar sind

4. Schonender bzw. effizienter Umgang mit Ressourcen im Crawl-Prozess (Serverinfrastruktur sowie Traffic)

Wie werden diese Ziele erreicht, bzw. was beeinflusst das Crawl-Budget einer Domain? Zuerst einmal das Alter der Domain. Denn je länger diese im Internet (aktiv) besteht, desto mehr Vertrauen hat Google in sie. Wenn auch noch ein positives Linkprofil vorherrscht und die Inhalte aktuell sind und regelmäßig gepflegt und ergänzt werden, steigt das von Google vergebene Crawl-Budget. Natürlich sollten die wichtigsten Links dazu erreichbar sein (im besten Falle also 200er Statuscodes zurückgeben) und Duplicate, sowie Thin Content vermieden werden. Damit der Googlebot alle Inhalte schnell erfassen kann, sollte der PageSpeed natürlich auch stimmen

Mit einem sieben-Punkte-Plan zeigte Bastian dann wie Webmaster ihr Crawling-Budget steuern und somit gezielt die wichtigsten Seiten indexieren lassen können.

Idealerweise sind alle Inhalte maximal 3-5 Klicks entfernt

–Bastian Grimm

Learnings:

- #1 Wichtigste Inhalte zuerst

Die Inhalte mit der höchsten Priorität auf der Webseite sollten für Besucher und für den Googlebot maximal 3-5 Klicks entfernt sein. Eine Priorisierung kann beispielsweise nach dem Suchvolumen erfolgen. Diese Inhalte sollten dann im Idealfall über „einzigartige“ URLs erreichbar sein, also am besten über „sprechende URLs“ und keine generisch erstellten.

- #2 „Richtige Links“

Webmaster sollten sicherstellen, dass jede Unterseite schnell und nur durch einen Klick erreichbar ist. Dabei könne man sich an Wikipedia orientieren, wo Besucher über harte Keywordlinks direkt zu dem gewünschten Artikel gelangen. Für den Googlebot vereinfacht ein schema.org-Markup den Link korrekt zu interpretieren.

- #3 Crawler Kontrolle

Per robots.txt oder Robots-Meta-Tag können Webmaster bestimmen, welche Seiten einer Domain Google in den Index aufnehmen soll. Er empfiehlt die Verwendung des Robots-Meta-Tag für Seiten, die nicht in den Index sollen. Denn dann werden die Seiten zwar gecrawlt, was auf das Crawling-Budget geht, aber nicht teilweise indexiert und teilweise in den SERPs angezeigt, wie es bei Verwendung von robots.txt sein kann. Um Crawling-Budget zu sparen, hilft es natürlich auch Seiten vollständig zu löschen.

- #4 Weiterleitungen

Webmaster sollten an Weiterleitungen sparen, da diese natürlich das Crawling-Budget belasten. Auch wurde Mitte des Monats bekannt, dass der Googlebot höchstens fünf 301-Weiterleitungen hintereinander folgt und danach abspringt.

- #5 Canonical-Tag

Laut Bastian Grimm sollten Canonical-Tags oftmals eingespart werden. „Für Filter, zum Sortieren oder bei HTTP vs. HTTPS ist die Verwendung ‚OK'“, erklärte er.

- #6 X-Robots-Header

…Können beispielsweise für Verweise von PDFs auf ihr HTML-Äquivalent verwendet werden. - #7 Ladezeit

Der Sitespeed (engl. für Ladezeit) ist seit 2010 ein Rankingfaktor und das in doppelter Hinsicht. Denn wenn eine Webseite sehr langsam lädt, dann kann dies dazu führen, dass die Return-to-SERP-Rate ansteigt. Und diese spiegelt Google eine negative User Experience wider. Also sollten Webmaster darauf achten die Inhalte ihrer Webseite schnell bereitzustellen – so werden sowohl Besucher, als auch Googlebot glücklich gemacht.

Jens Fauldrath:

SEO Maintenance – SEO als Prozess verstehen

Der Geschäftsführer von takevalue Consulting GmbH, Jens Fauldrath, zeigt einige Einblicke in die interne Arbeit mit den Daten der Google Search Console und betont, dass SEO ein Prozess und kein Projekt ist.

Da SEO mit allen anderen Marketing-Aktivitäten eines Unternehmens einher gehen muss, erklärte Fauldrath, dass der SEO-Manager nicht am Rande der Organisationsstruktur eingeordnet werden müssen, sondern ganz zentral. So muss er in alle Projekte integriert sein und große Entscheidungs- und Gestaltungsfreiheit haben. Der SEO muss im Gegenzug natürlich alle Maßnahmen und Ergebnisse an das Management reporten. Dafür könnte man prima die Auswertungen aus der Search Console nehmen, erklärte er. Bei der Verwendung der Search Console wäre dies ein sinnvoller Prozess:

- Erhebung der Daten

- Sicherung der Daten (besonders wichtig, da SC die Daten nur 90 Tage speichert)

- Auswertung der Daten

Wenn SEOs hier auf Verzeichnisebene arbeiten, können die Ergebnisse noch besser und detailreicher betrachtet werden. Nachteile der Search Console sind die uneinsehbaren Zeitzonen, sodass nicht eindeutig ersichtlich wird, ob die Daten vom Tag der Erhebung sind oder eventuell schon älter. Damit Fehler und Probleme schnell gesehen werden, sollte auch hier auf eine Struktur und einen festen Prozess geachtet werden. So könnten SEOs regelmäßig alle Template-Typen (Übersichtsseite, Detailseite, Blogübersicht,Blogpost etc.) auf die richtige Verwendung von H1, title- und meta-description etc. prüfen.

Die Präsentation von Jens findet ihr hier:

Markus Klöschen:

Content Marketing: Vom leeren Blog zum Zitat in der FAZ

Markus Klöschen, der Head of SEO von textprovider, plauderte in seinem Panel ein bisschen aus dem Nähkästchen. So schaffte es textprovider mit einem Ratgeber-Artikel zum Thema „Vergleich: Benziner oder Diesel“ als wichtigster Zitatgeber in die Frankfurter Allgemeine Zeitung. Dies lag an vielen Faktoren, wie dem richtigen Zeitpunkt der Veröffentlichung (Stichwort #Dieselgate), guter Suchmaschinenoptimierung und wirklich hochwertigen Informationen im Artikel.

Schafft gute, optimierte Stücke Content. Denn Redakteure informieren sich häufig über Google. Hier müsst ihr dann auftauchen und überzeugen.

-Markus Klöschen

Markus stellte in seinem Vortrag einen möglichen Fahrplan für die Erstellung von Content vor:

Vor der Erstellung von Content:

- Zieldefinition

- Klares Briefing der Redakteure

- Mehrwertigen Content für dieses Ziel schaffen

Contentproduktion:

- Strukturierung der Themen

- Diverse Contentarten vorbereiten: Text, Infografiken, Video, E-Book

- Redaktionsplanung zur gezielten Verbreitung der Inhalte

- Saisonale Textvorbereitung (Artikel vor saisonalem Peak erstellen und publishen, bspw. Weihnachtsdeko-Ratgeber schon im Oktober veröffentlichen)

Erfolgskontrolle:

- Was lief gut?

- Was lief schlecht?

–> Learnings entwickeln und bei der nächsten Content-Produktion umsetzen

Learnings

- klare Zieldefinition vor der Erstellung von Inhalten

- saisonales Interesse beachten (vlg. Google Trends)

- hochwertigen Content produzieren

- Erfolgskontrolle: Aus Fehlern lernen

René Dhemant:

Website-Relaunch – eine unendliche SEO-Geschichte

Referent René Dhemant hat in seinem Vortrag über ein Thema gesprochen, dass so gut wie alle Webmaster interessieren wird und bei dem der ein oder andere sicherlich schon verzweifelt ist: Er referierte über den Website-Relaunch und zeigte seinen Zuhörern einige Beispiele, wie Relaunches in der Vergangenheit einen massiven Einbruch an Sichtbarkeit zur Folge hatten – auch von großen Domains.

Welche Relaunch-Fehler sorgen denn für einen solch massiven Sichtbarkeits-Verlust? Besonders gefährlich sind fehlende 301-Weiterleitungen von bestehenden Inhalten der alten Webseite auf ihr Pendant auf der neuen Webseite nach dem Relaunch. Wie ihr diese mittels PHP oder .htaccess umsetzt, zeigen wir Euch hier.

Doch es lauern weitere Fehler und Probleme, die im Vorfeld der Überarbeitung der eigenen Website beachtet und ausgeräumt werden sollten. In Anlehnung an das Kölsche Grundgesetz hat René Dhemant 11 Regeln aufgestellt, die Webmaster befolgen sollten, wenn sie einen Relaunch durchführen. Zwei der „Grundgesetze“ aus der Relaunch-Fibel zählen wir kurz auf: Webmaster sollen bei einem Relaunch offen für Neuerungen sein, die positive Effekte auf die User Experience der Besucher (§5 „Et bliev nix wie et wor“) haben. Sie sollten sich aber tunlichst nicht ihrem Schicksal fügen (Grundgesetz §7 „Wat wellste maache?“), sondern bei Weiterleitungs-Problemen immer darauf bestehen alte Inhalte mit guten Rankings auf die neue Präsenz mit umzuziehen. Andernfalls verliert im worst case die gesamte Domain an Sichtbarkeit.

Das kölsche Grundgesetz für den Webseite-Relaunch und die weiteren neun Artikel daraus findet ihr in der Präsentation von René:

Learnings:

- 301-Weiterleitungen von internen und externen Links nicht vergessen

- wirtschaftliche Ziele vor dem Relaunch definieren

- Google benötigt Zeit: bis zu 6 Monate Ranking- und Trafficverlust sind normal

- Nicht mehr benötigte Seiten konsequent löschen und mit 410 Statuscode markieren

- Relaunch vor Veröffentlichung kontrollieren

- bei Problemen sich nicht dem Schicksal fügen, sondern Lösungen finden

- Google liebt Kontinuität: häufige Relaunches vermeiden

Christian Solmecke:

SEO & Recht: Die größten Abmahngefahren für Suchmaschinenoptimierer

Der Rechtsanwalt und Partner der Medienrechts-Kanzlei WBS, Christian Solmecke, zeigte aktuelle Urteile im Online-Recht, sodass Abmahnungen vermieden werden können. Zu Beginn seines Vortrags stieg er in die Thematik der Impressumspflicht nach §5 TMG ein. So muss jedes Impressum mit zwei Klicks erreichbar sein – auch in sozialen Netzen wie Facebook. Dort lauert aktuell jedoch eine Gefahr: Bei Facebook ist zwar ein Impressum auf Unternehmes-Fanpages einbaubar, allerdings kann dieses mobil nicht aufgerufen werden, da der „Impressum“-Button schlichtweg fehlt. Hier besteht zurzeit Abmahngefahr.

In Punkto Facebook gilt es weitere Dinge zu beachten: So werden beim Upload eines privaten Fotos automatisch alle Rechte an diesem Foto auch an Facebook übertragen – alles geregelt durch die Facebook-Richtlinien. Das soziale Netzwerk kann gar die eigene Fanpage umziehen. Dies ist bei der Stadt München passiert. Da Facebook die Präsenz unter www.facebook.com/muenchen selber betreiben wollte, zog man die Fanpage von München kurzerhand auf eine neue URL um.

Weitere Learnings in Bezug auf Facebook:

- ab einer bestimmten Anzahl Facebook-Freunde sind auf der eigenen FB-Seite kundgetane Äußerungen öffentlich (Richtwert >50 Freunde)

- einen Beitrag zu liken, bedeutet im weitesten Sinne Zustimmung – kann rechtlich als die eigene Äußerung/Meinung angesehen werden

- teilen von Zeitungsartikeln kann abgemahnt werden (Vorschaubilder fallen unter Urheberrecht)

- „Embedding“ von Artikeln, Tweets, Instagram-Posts oder YouTube-Videos ist nur Verlinkung und daher nicht abmahnfähig. Es sei denn, die Inhalte wurden ursprünglich illegal hochgeladen oder fallen unter das Persönlichkeitsrecht

Learning in Bezug auf „fremde Inhalte“:

Der Betreiber einer Webpräsenz mit Nutzern, die dort Inhalte posten können, beispielsweise eines Forums, muss urheberrechtlich geschützte Inhalte erst entfernen, wenn er von ihrer Existenz auf seiner Webpräsenz Notiz genommen hat.

„Notice and take down“

– Christian Solmecke

Learning in Bezug auf Twitter:

Wenn Personen Links in einem Tweet absetzen, sind sie für diesen Link und die damit verbreiteten Inhalte haftbar. Diese Haftung erlischt auch nicht, wenn sie einen Disclaimer in Form von „Ich hafte nicht für Links“ verwenden.

Johannes Beus:

Google Search Console – Was zeigen uns Googles Rankingdaten?

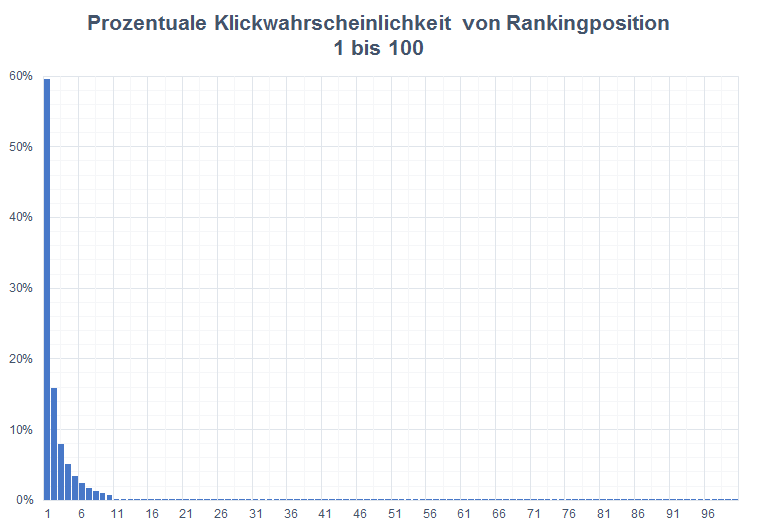

SISTRIX-Geschäftsführer Johannes Beus hat die Daten der Google Search Console API in Bezug auf die Klickwahrscheinlichkeit der organischen Suchergebnisse ausgewertet und seine Ergebnisse dem interessierten Publikum präsentiert.

Einige SISTRIX-Kunden hatten ihre Daten für eine anonyme Zusammenfassung zur Verfügung gestellt – so kamen sagenhafte 124.086.615 Klicks zustande. Eine ordentliche Datenbasis.

Die Verteilung der Klickwahrscheinlichkeit nach Rankingpositionen zeigt ein eindeutiges Bild. 99,1% aller Klicks auf organische Suchergebnisse fallen auf die ersten zehn Positionen:

Und hier entfallen fast 60% der Klicks auf Position 1. Erstaunlich ist, dass Desktop-Nutzer überdurchschnittlich häufig auf das erste Suchergebnis klicken, Smartphone- und Tablet-Nutzer dagegen eher auf die Positionen 2-4:

Alle weiteren Ergebnisse findet ihr in unserem Blogpost.

Kaspar Szymanski:

Penalty Recovery – Tipps vom Ex-Googler

In seinem halbstündigen Panel hat Kaspar Szymanski einige spannende Tipps für eine erfolgreiche Recovery nach einer manuellen Penalty verraten. So betonte er nochmal, dass es sich lediglich bei der manuellen Maßnahme um eine Strafe handelt. Ranking-Einbußen durch ein Algorithmus-Update sind ärgerlich, aber bei Google nicht als direkte Strafe angesehen – sie dienen vielmehr der Verbesserung der Qualität im Internet.

Da eine manuelle Maßnahme nicht ausgesessen werden kann, muss aktiv dafür gearbeitet werden, von Google daraus wieder entlassen zu werden:

Ladet Freitags das Disavow-File hoch und stellt den Reconsideration Request am Montag – wenn alle noch gute Laune vom Wochenende haben.

-Kaspar Szymanski

Das Google-System braucht rund 48 Stunden um eine Disavow-File zu verarbeiten. Anschließend sollte der Antrag auf Wiederaufnahme (Reconsideration Request) gestellt werden. Bevor dieser gestellt wird, sollten Webmaster alle Inhalte, die gegen die Google Webmaster Guidelines verstoßen, entfernen. Auch sollte man im Reconsideration Request geloben in der Zukunft nicht mehr zu spammen. Beim ersten Reconsideration Request ist Google meist gütig, sofern alle SPAM-Inhalte entfernt wurden. Spammen Webmaster allerdings wiederholt, wird Google strenger und unerbittlicher.

Learnings:

- Disavow-File wird in rund 48 Stunden verarbeitet

- Manuelle Maßnahme kann nicht ausgesessen werden

- Webmaster Guidelines werden laufend aktualisiert und sollten immer in ihrer aktuellsten Version überprüft werden

- mit einer manuellen Maßnahme können gesamte Domains, einzelne Subdomains oder auch einzelne HTML-Seiten bestraft werden

Jakob Holterhöfer:

Developing for PageSpeed

Software-Entwickler Jakob Holterhöfer widmete sich in seinem Vortrag dem Thema Ladezeit und kreiste schnell einen zentralen Schuldigen ein:

Es ist fast immer die Datenbank

– Jakob Holterhöfer

Denn vor allem Content-Management-Systeme wie WordPress würden unnötig viele einzelne Datenbankabfragen beim Aufruf einer Webseite starten, wodurch die Antwortzeit des Servers unnötig langsam werden würde.

Weitere Problemstellen bei der Ladezeit von Webseiten sind folgende:

- Bilderoptimierung – kann gelöst werden, indem direkt die benötigte Größe des Bildes ausgegeben wird

- Caching – Jakob empfiehlt die Verwendung von mod_cache mit Versionsnummern für statische Ressourcen (test.jpg?v=aab3ac4gf)

- Code-Reduktion durch Zusammenfassung und Minifizierung von Text-Ressourcen

- Inhalte, die das Rendering blockieren

- Kompression – idealerweise mod_deflate zur Kompression nutzen

- Rendering above the fold

- Redirects – diese sollten vor allem mobil vermieden werden, da sie zu einer negativen User Experience beitragen

Learnings:

- Datenbankanfragen wenn möglich reduzieren

- nur wenige Redirects verwenden

- Bilder optimieren und direkt in der benötigten Größe (angepasst an Gerätebildschirm) ausgeben

- mod_cache für das Caching verwenden

Malte Landwehr:

Häufige SEO-Fehler

Im letzten Panel des Tages zeigte Malte Landwehr einige SEO-Fehler, die auch noch im Jahre 2015 vorkommen.

Um diese zu vermeiden gab er seinen Zuhörern einen Leitfaden an die Hand, an welchen sie sich halten sollten um diese Fehler zu vermeiden:

- Title-Tag befüllen

- Ziel bei 301-Weiterleitung nicht vergessen

- Pagination nicht mit „vor“ und „zurück“ sondern mittels 1,2,3,4,… umsetzen

- Holistische Texte schreiben, die mehrere Facetten einer Thematik abbilden

- Content-Maintenance betreiben, also bestehenden Content regelmäßig pflegen und aktualisieren und bestenfalls Evergreen-Content erstellen

SuperPanel

Auch in diesem Jahr gab es wieder ein SuperPanel und in diesem Kontext wurden auch die besten Speaker ausgezeichnet. Der dritte Platz ging an Gero Wenderholm, der Zweite an Bastian Grimm und der erste Platz an Jens Fauldrath. Herzlichen Glückwunsch an Euch drei!

Street View im Rhein-Energie-Stadion: Bewege Dich durch die Räumlichkeiten des SEO DAY 2015

Dank Christoph Gotzmann von gefunden.net haben all diejenigen, die dieses Jahr nicht auf dem SEO DAY sein konnten, nun die Möglichkeit die Räume virtuell zu besuchen. Da die Aufnahmen früh am Morgen entstanden sind, ist es noch etwas leerer. Doch so kann man alle Messestände in ihrer vollen Pracht bewunden. Findet ihr auch unseren SISTRIX-Stand?

Fazit und Rückblick

Auch die fünfte Auflage des SEO DAY war ein voller Erfolg. Fabian Rossbacher und sein gesamtes Team haben tolle Arbeit geleistet und zur besseren Vernetzung der SEO Welt und einem gelungenen Wissensaustausch beigetragen.

Den SEO DAY gibt es seit 2011 und entsprang einer Idee bei einem SEO Stammtisch. Aus der ursprünglichen Idee ist nun die größte Konferenz der Suchmaschinenoptimierer im Rheinland entstanden und die wachsenden Besucherzahlen zeigen: Die Branche wächst weiter. Denn waren es 2011 noch 450 Besucher, so strömten dieses Jahr über 800 SEOs und Interessierte in das Rhein-Energie-Stadion. Die längste Anreise nahm übrigens ein Besucher aus Malta auf sich.

Unser Recap vom SEO DAY 2014 findet ihr hier.