Seit jeher lässt Google die Qualität seiner Suchergebnisse durch sogenannte Google Search Rater für interne Zwecke bewerten. Nun gibt es Hinweise, dass diese Search Rater auch konkret Einfluss auf die SERPs nehmen.

Wenn es um die genau Rolle der Google Search Rater geht, ist Google eher zurückhaltend. Zwar sind die Search Quality Rater Guidelines, eine Art Arbeitsanweisung für diese Personen seit ein paar Jahren auch öffentlich verfügbar – welche genauen Auswirkungen ihre Arbeit aber hat, ist bislang ungeklärt.

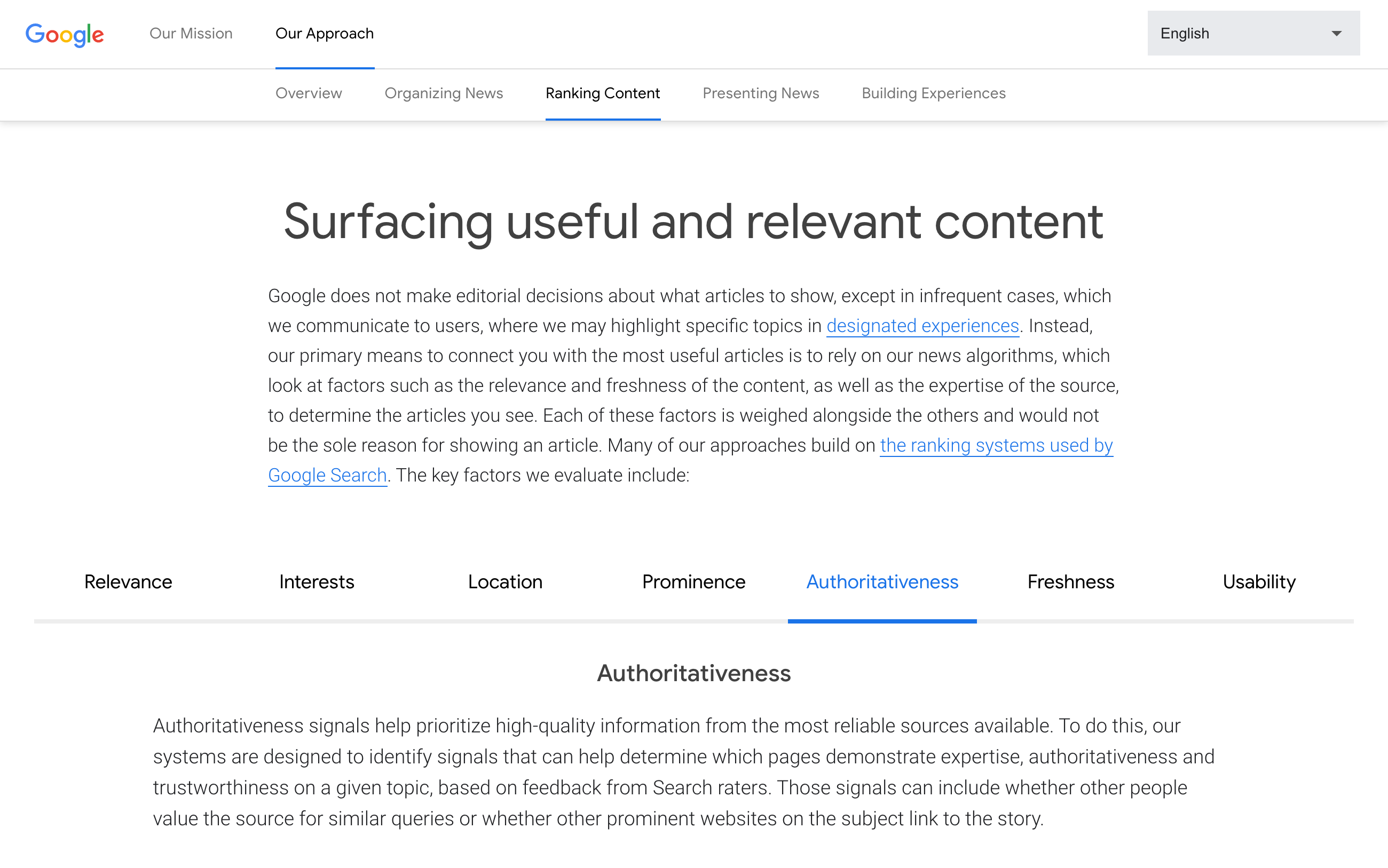

Auf einer Seite, die Google im Rahmen der I/O-Konferenz veröffentlicht hat und bei der es eigentlich eher um Google News gibt, finden sich nun aber mehr Informationen. So schreibt Google dort:

Many of our approaches build on the ranking systems used by Google Search.

Weiter unten unter dem Punkt “Authoritativeness” dann:

To do this, our systems are designed to identify signals that can help determine which pages demonstrate expertise, authoritativeness and trustworthiness on a given topic, based on feedback from Search raters.

Als SEO wird bei der Aneinanderreihung von “Expertise, Authoritativeness and Trustworthiness” schnell die Abkürzung E-A-T und ein Bezug zu den letzten Google-Core-Updates herstellt. Allgemeine Meinung ist, dass Google bei diesen Updates erhöhte Aufmerksamkeit auf diese drei Themen gelegt hat.

Durch die oben zitierte Bestätigung wird nun auch klar, dass die Google Search Rater hierbei einen maßgeblichen Einfluss haben. Von Google beschäftigte Menschen und nicht Algorithmen sind die Grundlage zur Identifizierung und Einschätzung von Webseiten. Google wird, wie vermutet, diese Erkenntnisse durch einen Machine-Learning-Ansatz auf viele Webseiten übertragen – den ersten Schritt und die Definition der Ursprungsdaten stammt aber von Menschen.