An der Keyworddichte als Rankingfaktor scheiden sich die Geister: für die einen ist sie ein Blick zurück auf den Anfang dieses Jahrtausends als häufiges Wiederholen des Keywords im Text und Dateinamen einen bei Fireball wirklich weit nach vorne brachte, für die anderen ist der prozentuale Anteil, den das Keyword an einem Fließtext ausmacht noch heute täglicher Maßstab ihrer SEO-Arbeit. Da die Wahrheit, wie so häufig, irgendwo zwischen diesen beiden Extremen liegen wird, habe ich mir ein paar Gedanken zur Keyworddichte gemacht und versuche, ihr anhand eines Tests – zumindest teilweise – auf den Grund gehen zu können.

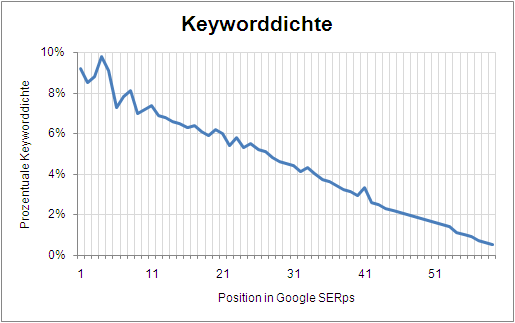

Die Grundüberlegung für folgenden Test war, dass Google Seiten, die einen höheren Wert haben, besser rankt, als solche mit einer niedrigen Keyworddichte (unter der Bedingung, dass alle anderen Faktoren gleich sind). Darauf aufbauend habe ich diesen Test aufgesetzt: eine Menge sinnloser Fließtexte, die sich einzig in der Keyworddichte unterscheiden – hier sind alle Werte zwischen 0,1 und 10% vorhanden. Alle anderen möglichen Faktoren habe ich versucht gleich zu halten. Von Interesse ist nun: welche Seiten stehen bei der Suche nach dem Keyword vorne? Überraschenderweise sind es wirklich die Texte mit einer möglichst hohen Keyworddichte: auf der ersten Seite findet sich alles zwischen 7,0 und 9,8%. Schaut man sich das Ganze mal für die ersten 60 Positionen an, so sieht das so aus:

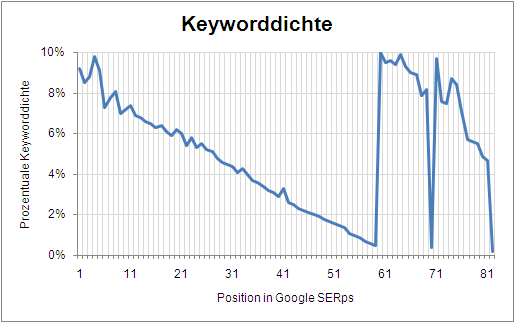

Auf den ersten Blick eine relativ klare Sache: je höher die Keyworddichte, desto besser. Hm, wär‘ zu einfach, oder? Leider richtig. Als ich nämlich den Rest der Ergebnisse in meine Excel-Tabelle eingetragen habe, kam folgendes Ergebnis raus:

Sieht jenseits von Position 60 erstmal ganz schön wüst aus. Meine Erklärung ist nun folgende: Wie bekannt, versucht Google Manipulationen der SERPs zu unterbinden. Dafür gibt es vielfältige Möglichkeiten, die allseits bekannten „Filter“ sind eine davon. Fällt eine Seite – durch was auch immer – ausreichend negativ auf, geht es erst einmal nach hinten. Die „Strafversetzung“ auf die Plätze jenseits der 60 ist als Strafe beliebt, man spricht auch von einer „Penalty +60“. Genau das scheint hier der Fall zu sein. Die Seiten haben es, weswegen auch immer, in einen oder mehrere Filter geschafft und wurden nach hinten durchsortiert. Vor einiger Zeit habe ich unter dem Titel „Ist das noch normal?“ etwas dazu geschrieben, wie Google Abkehrungen von der „Normalität“ im Index erkennen kann, vielleicht trifft das ja hier zu.

Welche Schlüsse ergeben sich nun aus diesem Test? Zum einen ist die Keyworddichte klar ein Rankingfaktor. Mehr ist hier gleich besser, ein Limit nach oben scheint es in (sinnvollen) Grenzen erstmal nicht zu geben. Allerdings besteht mit zunehmender Keyworddichte eine deutlich erhöhte die Gefahr, dass die Seite deswegen in einen Filter gerät und nach hinten durchgereicht wird – ein Wert zwischen 1,0% und 4,0% liegen nach diesem Test innerhalb der sicheren Parameter und ich würde mich ehrlich gesagt auch wundern, wenn man diesen Wert in einem gut lesbaren Fließtext sinnvoll überschreiten könnte.