Während wir in Kontinentaleuropa gespannt auf die Umsetzung des Panda Updates warten, kehrt in den USA sowie in England langsam etwas Ruhe ein. Dort sind die Anpassungen bereits durch und der Staub hat sich etwas gelegt. Für ein endgültiges Fazit des Panda-Updates ist es sicherlich noch zu früh, ich möchte trotzdem einige Überlegungen und Rückschlüsse zur Diskussion stellen.

Die Ursache hat das Panda-Update in Google Caffeine. Unter dem Stichwort Caffeine hat Google im letzten Jahr eine grundlegende Überarbeitung der Such-Infrastruktur durchgeführt. Seitdem können neue Seiten und Rankingsignale deutlich schneller in den Index aufgenommen werden, aber auch die Gesamtgröße des Google-Index hat massiv zugelegt. Und genau das wurde zum Problem für Google: dadurch, dass vor Caffeine nur eine begrenzte Anzahl an URLs von Domains mit Inhalten von zweifelhafter Qualität indexiert wurden, hat das wie ein natürlicher Filter gewirkt. Dieser Filter ist durch Caffeine nun weggefallen und etliche, qualitativ eher minderwertige Inhalte sind in den Index gekommen und werden folglich auch gefunden. Mit Panda möchte Google das Problem nun wieder in den Griff bekommen und Inhalte, die zwar nicht klar gegen die Spam-Richtlinien verstoßen, aber trotzdem nicht den Qualitätserwartungen von Google (und den Nutzern) entsprechen, aus dem Ranking verbannen.

Zu Domains, die von Panda betroffen sind, habe ich in den vergangenen Wochen einiges geschrieben. Das erste Panda-Update in den USA hat sicherlich für die meiste Aufregung gesorgt, aber auch die UK-Version sowie das Update in den USA liefern interessante Daten. Über mögliche Ursachen wird seitdem diskutiert: einige vertreten die Auffassung, dass Google den Anteil der Brand-Suchen heranzieht, viele glauben, dass Google die Qualität von Texten bewerte und wieder andere denken, dass eine Reduzierung der Anzahl von indexierten Seiten helfen könne. Da wir bislang noch keine Domain gesehen haben, die sich nachhaltig von Panda erholt hat, ist es etwas früh, Lösungen zu entwickeln. Ich persönlich glaube, dass Google eine Vielzahl von Signalen parallel auswertet. Wenn eine ausreichend große Anzahl dieser Signale für eine Domain eine zu große Abweichung vom Standard feststellen, schlägt der Filter zu. Interessant ist nun die Spekulation über mögliche Signale, die in die Bewertung der Domain einfließen. Aktuell scheint Google sich hierbei übrigens noch auf domain-weite Signale zu beschränken, wie der Kommentar eines Google-Mitarbeiters in den Support-Foren verrät:

Zu Domains, die von Panda betroffen sind, habe ich in den vergangenen Wochen einiges geschrieben. Das erste Panda-Update in den USA hat sicherlich für die meiste Aufregung gesorgt, aber auch die UK-Version sowie das Update in den USA liefern interessante Daten. Über mögliche Ursachen wird seitdem diskutiert: einige vertreten die Auffassung, dass Google den Anteil der Brand-Suchen heranzieht, viele glauben, dass Google die Qualität von Texten bewerte und wieder andere denken, dass eine Reduzierung der Anzahl von indexierten Seiten helfen könne. Da wir bislang noch keine Domain gesehen haben, die sich nachhaltig von Panda erholt hat, ist es etwas früh, Lösungen zu entwickeln. Ich persönlich glaube, dass Google eine Vielzahl von Signalen parallel auswertet. Wenn eine ausreichend große Anzahl dieser Signale für eine Domain eine zu große Abweichung vom Standard feststellen, schlägt der Filter zu. Interessant ist nun die Spekulation über mögliche Signale, die in die Bewertung der Domain einfließen. Aktuell scheint Google sich hierbei übrigens noch auf domain-weite Signale zu beschränken, wie der Kommentar eines Google-Mitarbeiters in den Support-Foren verrät:

„In addition, it’s important for webmasters to know that low quality content on part of a site can impact a site’s ranking as a whole.“

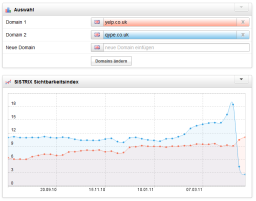

Für einen näheren Blick finde ich qype.co.uk sowie yelp.co.uk recht interessant: beide haben das gleiche Geschäftsmodell, doch Yelp blieb in UK von Panda verschont, während es Qype getroffen hat. Viele Daten der beiden Domains sind recht ähnlich, doch schaut man sich Verweildauer, PageView pro Nutzer und Bounce-Rate an, fallen Unterschiede auf. Im Folgenden übrigens mit den Alexa-Daten. Mit ist durchaus bewusst, dass man die Daten mit Vorsicht anfassen muss, in diesem Fall geht es aber um zwei sehr ähnliche Seiten und deren Unterschiede, daher müsste es funktionieren:

| Qype.co.uk | Yelp.co.uk | |

|---|---|---|

| PV/User | 3,15 | 4,39 |

| Bounce % | 61,7% | 52,0% |

| Time on Site | 2,6 min | 4,8 min |

Auffällig, dass Yelp hier bei diesen Metriken durchgehend besseren Werte erzielt. Auch bei vergleichbaren „Domain-Paaren“ (eine durch Panda betroffen, eine andere Domain nicht), habe ich häufig deutliche Unterschiede in diesen Kennzahlen gesehen. Hier zum Beispiel für Pricerunner.co.uk sowie Ciao.co.uk:

| Ciao.co.uk | Pricerunner.co.uk | |

|---|---|---|

| PV/User | 2,11 | 3,10 |

| Bounce % | 63,2% | 47,6% |

| Time on Site | 1,7 min | 2,5 min |

Bei diesen Werten würde ich übrigens nicht auf die absoluten Zahlen schauen, sondern eher auf die Abweichung der jeweiligen Domain im Vergleich zur Konkurrenz. Auch, wenn noch unklar ist, ob Google diese Werte in die Entscheidung über den Panda-Filter einfließen lässt, spricht aus meiner Sicht derzeit einiges dafür. Allerdings werden noch zahlreiche weitere Signale in diese Entscheidung einfließen.