Jeden Tag werden mehrere Millionen neuer URLs im Internet veröffentlicht, Suchmaschinen haben also viel zu tun, alle diese Seiten zu crawlen. Um Ressourcen zu schonen, hat Google im Jahr 2017 das „Crawl Budget“ erstmals als Konzept vorgestellt und erklärt, was es für SEO in der Praxis bedeutet.

- Crawl Budget – Eine aktuelle Definition von Google

- Crawling-Frequenz (Crawl Rate Limit)

- Crawling-Bedarf (Crawl Demand)

- Faktoren, die das Crawl Budget maßgeblich beeinflussen

- URLs mit geringem oder keinem Mehrwert

- Technische Probleme

- Wie SISTRIX dir bei der Optimierung deines Crawl Budgets hilft

- Für wen ist das Crawl Budget wirklich relevant

- Tipps zur Optimierung des Crawl Budgets

- Aufräumen deiner URLs

- Verbesserung der Website-Leistung

- Bessere Struktur und Verlinkung

- Qualität und Aktualität der Inhalte

Crawl Budget – Eine aktuelle Definition von Google

Das Crawl Budget ist nicht einfach die maximale Anzahl an Unterseiten, die der Googlebot crawlen kann. Vielmehr beschreibt es die Menge an Ressourcen, die Google bereit ist, für das Crawling einer bestimmten Website aufzuwenden. Es ist die Kombination aus der Crawling-Frequenz (Crawl Rate) und dem Crawling-Bedarf (Crawl Demand).

Crawling-Frequenz (Crawl Rate Limit)

Dieses Limit bestimmt, wie viele Anfragen der Googlebot gleichzeitig an eine Website senden kann und wie lange er zwischen diesen Anfragen wartet. Es wird maßgeblich von der Crawl Health beeinflusst, also der Fähigkeit der Website, schnell und zuverlässig auf Anfragen zu reagieren. Eine hohe Serverlast, langsame Antwortzeiten oder häufige Serverfehler (z. B. 5xx-Statuscodes) reduzieren die Crawling-Frequenz, da Google die Website nicht überlasten möchte. Eine konstant schnelle und stabile Website kann hingegen eine höhere Frequenz fördern. Du kannst in der Google Search Console eine maximale Crawling-Frequenz einstellen, aber diese Einstellung garantiert nicht, dass Google diese Frequenz auch tatsächlich nutzt. Sie dient eher dazu, eine Überlastung deines Servers zu verhindern.

Crawling-Bedarf (Crawl Demand)

Dies ist Googles Einschätzung, wie wichtig es ist, eine Website oder bestimmte URLs auf dem neuesten Stand zu halten. Der Bedarf hängt von mehreren Faktoren ab:

- Beliebtheit der URLs: URLs, die viele Backlinks erhalten, viel Traffic generieren oder in Sitemaps als wichtig markiert sind, werden als wichtiger erachtet und erhalten in der Regel einen höheren Crawling-Bedarf.

- Aktualität der Inhalte: Websites, die regelmäßig neue Inhalte veröffentlichen oder bestehende Inhalte aktualisieren, signalisieren Google, dass sie oft neu gecrawlt werden sollten.

- Erkannte Änderungen: Größere strukturelle Änderungen, wie ein Domainwechsel oder umfangreiche Neustrukturierungen, können vorübergehend den Crawling-Bedarf erhöhen, da Google die neue Struktur erfassen muss.

- Veraltete Inhalte: Wenn Inhalte als veraltet oder irrelevant eingestuft werden, reduziert Google den Crawling-Bedarf für diese URLs.

Wichtig: Es ist essenziell, das Crawl Budget nicht mit dem Index Budget zu verwechseln. Das Crawl Budget bezieht sich auf den Prozess des Entdeckens und Abrufens von URLs. Das Index Budget hingegen bezieht sich darauf, welche der gecrawlten URLs tatsächlich in den Google-Index aufgenommen werden. Eine Seite kann gecrawlt werden (verbraucht also Crawl Budget), aber dennoch nicht indexiert werden (z. B. aufgrund von noindex-Anweisungen oder Qualitätsmängeln). Fehlerseiten (404/410) verbrauchen Crawl Budget, werden aber nicht indexiert.

Faktoren, die das Crawl Budget maßgeblich beeinflussen

Google hat klar dargelegt, welche Faktoren sich negativ auf das Crawl Budget auswirken und somit die Effizienz des Crawlings beeinträchtigen. Das Ziel ist es, dem Googlebot so wenige Sackgassen und Zeitfresser wie möglich zu präsentieren.

URLs mit geringem oder keinem Mehrwert

Dies ist der Hauptfaktor, der das Crawl Budget unnötig belastet. Dazu gehören:

- Soft 404s: Seiten, die einen 200-OK-Statuscode zurückgeben, aber inhaltlich leer sind oder als „nicht gefunden“ fungieren (z. B. generische Fehlerseiten ohne echten 404).

- Gehackte Seiten: Kompromittierte Seiten mit Spam-Inhalten verschwenden Crawl Budget und schaden dem Ranking.

- Duplizierte Inhalte: Seiten mit identischem oder nahezu identischem Inhalt, die über verschiedene URLs erreichbar sind, zwingen den Googlebot, redundante Informationen zu crawlen.

- Spam und minderwertige Inhalte: Seiten mit wenig bis keinem Mehrwert, die hauptsächlich dazu dienen, Keyword-Stuffing zu betreiben oder aggressive Werbung anzuzeigen.

- Facettennavigation und Session IDs: URLs, die durch Filter, Sortieroptionen oder Session-Parameter entstehen und keine einzigartigen, indexierungswürdigen Inhalte bieten.

- Infinite Spaces: Dynamisch generierte URLs, die ins Unendliche gehen könnten und keinen echten Wert bieten (z. B. Kalender mit Vor- und Zurück-Funktion, die unbegrenzt weit in die Zukunft oder Vergangenheit führen).

Technische Probleme

- Serverfehler (5xx-Statuscodes): Wenn der Server nicht erreichbar ist oder Fehler zurückgibt, reduziert Google die Crawling-Frequenz, um den Server nicht weiter zu belasten.

- Langsame Ladezeiten: Jede Seite, die lange zum Laden braucht, bindet den Googlebot länger und reduziert die Anzahl der pro Zeiteinheit crawlbaren Seiten.

- Weiterleitungsketten: Mehrere hintereinander geschaltete Weiterleitungen (z. B. URL A → URL B → URL C) verbrauchen unnötig Crawl Budget und können zu Fehlern führen.

- Fehlerhafte Links (404/410): Auch wenn diese nicht indexiert werden, verbrauchen sie Ressourcen beim Crawling.

In all diesen Fällen musst du damit rechnen, dass Google seine Crawling-Aktivitäten auf deiner Website reduziert, da es Ressourcen effizient einsetzen möchte.

Wie SISTRIX dir bei der Optimierung deines Crawl Budgets hilft

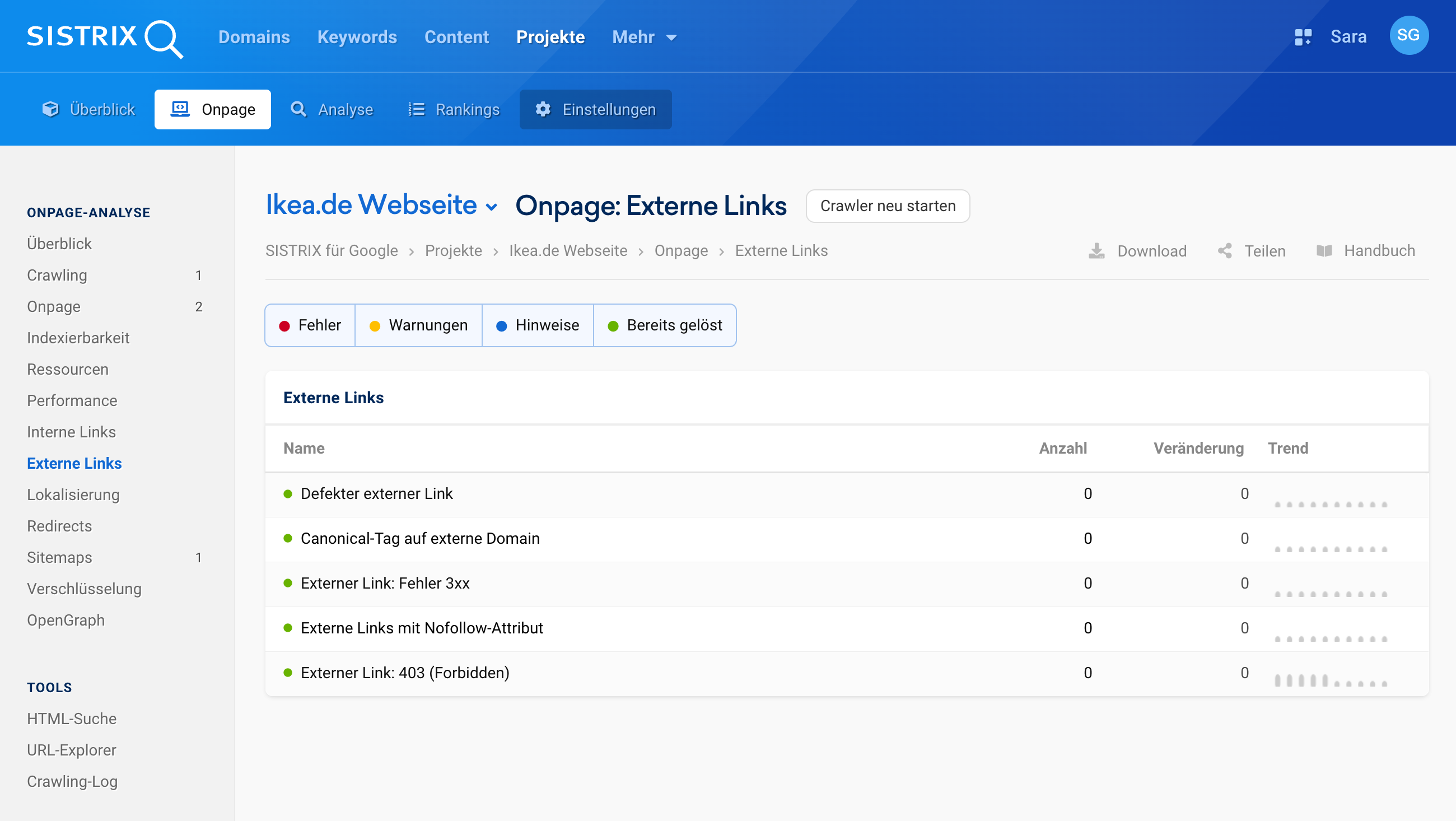

SISTRIX hilft dir dabei, dein Crawl Budget gezielt im Blick zu behalten und sinnvoll zu nutzen – besonders bei großen oder dynamischen Websites. Mit den Onpage-Projekten kannst du deine Seite regelmäßig crawlen lassen und so frühzeitig technische Probleme erkennen, die das Crawl Budget belasten. Dazu zählen zum Beispiel fehlerhafte Weiterleitungen, 5xx-Fehler, lange Ladezeiten oder zu viele Seiten mit wenig Mehrwert. Gleichzeitig bekommst du detaillierte Daten zu Duplicate Content, interner Verlinkung und der Sichtbarkeit einzelner URLs. So kannst du klar entscheiden, welche Seiten Priorität haben sollen und sicherstellen, dass der Googlebot die relevanten Inhalte effizient findet und crawlt.

Teste selbst, wie du dein Crawl Budget mit SISTRIX gezielt optimieren kannst, damit Google deine wichtigsten Inhalte zuerst findet. Teste SISTRIX 14 Tage kostenlos und starte direkt mit der Analyse deiner Website.

Für wen ist das Crawl Budget wirklich relevant

Google hat 2017 seine Position präzisiert: Für die allermeisten Websites ist das Crawl Budget kein kritisches Problem!

Betreiber von kleinen und mittleren Websites (bis zu einigen zehntausend, teilweise auch hunderttausend URLs), die nicht täglich eine Vielzahl neuer URLs Inhalte veröffentlichen, müssen sich in der Regel keine Sorgen um ihr Crawl Budget machen. Google hat ausreichend Kapazitäten, um diese Websites regelmäßig und vollständig zu crawlen, solange keine gravierenden technischen Probleme vorliegen.

Das Crawl Budget wird erst dann zu einem wichtigen Optimierungsfaktor, wenn eine Website eine der folgenden Eigenschaften aufweist:

- Sehr große Websites: Websites mit Hunderttausenden oder gar Millionen von URLs (z. B. große Online-Shops, Nachrichtenportale mit riesigen Archiven, Foren mit sehr vielen Unterseiten).

- Websites mit sehr dynamischen Inhalten: Portale, die minütlich oder stündlich neue Artikel, Produkte oder andere Inhalte veröffentlichen.

- Websites, die häufig ausfallen oder technische Probleme haben: Wenn der Server oft ausfällt oder sehr langsam ist, wird Google die Crawling-Frequenz automatisch drosseln, unabhängig von der Größe der Website.

- Websites mit hohem Anteil an „Discovered – currently not indexed“ in der Search Console: Wenn viele URLs im Indexabdeckungsbericht diesen Status haben, kann das ein Hinweis darauf sein, dass Google die URLs kennt, aber das Crawl Budget nicht ausreicht oder andere Gründe eine Indexierung verhindern.

Tipps zur Optimierung des Crawl Budgets

Damit Google deine wichtigsten Inhalte schneller findet und in den Suchergebnissen anzeigt, solltest du den Googlebot gezielt lenken.

Aufräumen deiner URLs

- Unwichtige Seiten sperren: Nutze die robots.txt-Datei, um Google von Seiten fernzuhalten, die nicht in den Suchergebnissen erscheinen sollen.

- Seiten aus dem Index halten: Nutze noindex, wenn Seiten nicht in den Suchergebnissen erscheinen sollen.

- Doppelte Inhalte kennzeichnen: Verwende Canonical-Tags, um Google die Original-URL zu zeigen.

- Seiten korrekt melden:

- Dauerhaft gelöschte Seiten → Statuscode 410

- Umgezogene Seiten → 301-Weiterleitungen ohne Ketten

Verbesserung der Website-Leistung

- Schnelle Ladezeiten: Je schneller deine Seiten laden, desto mehr Seiten kann der Googlebot bei jedem Besuch prüfen.

- Stabile Server: Sorge dafür, dass dein Webserver immer erreichbar und leistungsfähig ist.

Bessere Struktur und Verlinkung

- Logischer Aufbau: Gestalte deine Website so, dass wichtige Inhalte mit möglichst wenigen Klicks von der Startseite erreichbar sind.

- Smarte interne Links: Verlinke von wichtigen auf weniger wichtige Seiten, um Google die Priorität deiner Inhalte zu zeigen.

- Sitemaps nutzen: Reiche eine aktuelle Sitemap in der Google Search Console ein, damit Google neue Inhalte schneller findet.

Qualität und Aktualität der Inhalte

- Konzentriere dich auf Mehrwert: Erstelle Inhalte, die für deine Nutzer wirklich nützlich und einzigartig sind.

- Regelmäßig aktualisieren: Pflege deine Inhalte regelmäßig. Aktive Websites werden häufiger gecrawlt.

Auch wenn das Crawl Budget für die meisten Websites kein direkter Ranking-Faktor ist, sind die Maßnahmen zur Optimierung ohnehin Teil einer guten SEO-Strategie. Sie verbessern die User Experience, die allgemeine Crawlability und Indexierbarkeit, was sich indirekt positiv auf die Sichtbarkeit auswirkt. Für große Publisher ist das bewusste Management des Crawl Budgets jedoch unerlässlich, um sicherzustellen, dass ihre wertvollen Inhalte von Google optimal erfasst werden.

Die Google Search Console stellt mit dem Crawl-Statistik-Bericht und dem Indexabdeckungsbericht zwei zentrale Werkzeuge bereit, um die Aktivitäten des Googlebots im Detail nachzuvollziehen und potenzielle Probleme zu erkennen. So lässt sich etwa sehen, wie oft Google deine Seiten abruft, welche Statuscodes dabei zurückgegeben werden und ob bestimmte Bereiche der Website seltener gecrawlt werden. In Kombination mit den Analysen in SISTRIX kannst du diese Daten gezielt auswerten, technische Schwachstellen priorisieren und sicherstellen, dass wichtige Inhalte zuverlässig erfasst werden.

SISTRIX kostenlos testen

- Kostenloser Testaccount für 14 Tage

- Unverbindlich, keine Kündigung notwendig

- Persönliches Onboarding durch Experten