KI-Suchmaschinen sind mehr als nur ein technisches Update der klassischen Suche. Spätestens mit Googles neuem KI-Modus, der generative Antworten direkt in die reguläre Suche integriert, ist klar: Die Art, wie Informationen gefunden und dargestellt werden, verändert sich grundlegend. Nutzer erhalten zunehmend komplette Antworten, ohne eine Website besuchen zu müssen.

- Wie KI-Suchmaschinen funktionieren

- Crawling und Webzugriff

- Sprachverarbeitung durch LLMs

- Konsequenzen für Websites und SEO

- KI-Sichtbarkeit mit SISTRIX messen

- Projekt anlegen

- Prompts im Detail

- Wettbewerber im Blick

- KI-Suchmaschinen vs. KI-Chatbots mit Web-Zugriff

- KI-Suchmaschinen

- KI-Chatbots mit Web-Suche

- KI-Chatbots ohne Web-Suche

- Ausblick: Wird die KI-Suche die klassische Suche verdrängen?

- Quellen & Studien

KI-Suchmaschinen (wie Google KI-Modus, Perplexity oder KI-Chatbots mit Web-Zugriff) markieren das Ende der klassischen Link-Liste. Sie nutzen Large Language Models (LLMs) und eigene Indexe, um Suchanfragen in direkte, generierte Antworten umzuwandeln.

Für SEO bedeutet das: Rankings allein reichen künftig nicht mehr aus.

Um trotzdem Top-Sichtbarkeit zu sichern, musst du dich anpassen:

- Werde zitierfähig: Inhalte müssen als vertrauenswürdige Quelle (E-E-A-T) für die KI dienen, um künftig noch sichtbar zu sein.

- Mehrwert bieten: Setze auf klar strukturierte Inhalte und neue, einzigartige Perspektiven, die über allgemeines Wissen hinausgehen.

- Messe den Erfolg: Tools wie SISTRIX helfen, die eigene Nennung in generierten KI-Antworten messbar zu machen.

Die klassische Websuche, wie wir sie seit über zwei Jahrzehnten kennen, basiert auf einem einfachen Prinzip: Der Nutzer stellt eine Suchanfrage, die Suchmaschine liefert eine Liste mit Links. Diese sogenannten „blauen Links“ verweisen auf Webseiten, auf denen man hoffentlich die gesuchte Information findet. Grundlage dieses Modells sind Webcrawler, die das Internet systematisch erfassen, indexieren und so durchsuchbar machen.

Mit der Integration künstlicher Intelligenz in Suchmaschinen verändert sich dieses Paradigma grundlegend. Die Antwort auf eine Suchanfrage wird in KI Suchmaschinen nicht mehr ausschließlich aus einer Liste potenziell relevanter Webseiten zusammengestellt. Stattdessen verarbeitet das System die Informationen im Hintergrund und erstellt daraus eine neue, zusammenhängende Antwort. Nutzer sehen also nicht mehr nur Verweise auf Inhalte, sondern eine direkte Formulierung, die verschiedene Quellen zusammenführt. Diese Veränderung betrifft nicht nur die Art der Informationsverarbeitung, sondern auch die Erwartungen an Suchmaschinen insgesamt. Für SEO bedeutet das neue Chancen, aber auch neue Herausforderungen: Sichtbarkeit entsteht nicht mehr allein über Rankings, sondern darüber, ob Inhalte als Quelle in generativen Antworten auftauchen.

Wie KI-Suchmaschinen funktionieren

Um zu verstehen, wie KI-Suchmaschinen arbeiten, muss man zwei Systeme differenzieren: den Webzugriff (Crawling, Indexierung) und die Sprachverarbeitung (Generierung der Antwort).

Crawling und Webzugriff

Ein klassischer Web Crawler, wie ihn Google, Bing oder auch Perplexity einsetzen, durchsucht das Internet systematisch. Dabei folgt er Links von einer Seite zur nächsten, speichert Inhalte zwischen und legt sie in einem Index ab. Dieser Index bildet das Fundament, auf dem später Suchanfragen verarbeitet werden. Die Inhalte werden technisch strukturiert erfasst – als HTML, Text, Bilder, Metadaten – jedoch nicht semantisch verstanden.

KI-Suchmaschinen benötigen aktuelle Informationen, um relevante Antworten zu generieren. Einige Systeme betreiben dafür eigene Crawler, was allerdings sehr aufwändig ist. Bei hybriden Systemen – etwa ChatGPT mit Browsing-Funktion – wird keine eigene Indexierung vorgenommen. Stattdessen nutzt das Modell bestehende Suchmaschinen, etwa Google oder Bing, um im Moment der Anfrage gezielt Webseiten abzurufen. Die Auswahl dieser Seiten basiert auf dem Ranking der zugrunde liegenden Suchmaschine.

Im nächsten Schritt übernimmt dann das Sprachmodell: Es verarbeitet die Inhalte, bewertet den Kontext und formuliert daraus eine neue Antwort. Wie genau diese Sprachverarbeitung funktioniert und welche Konsequenzen das für SEO hat, erklären wir im weiteren Verlauf des Artikels.

Sprachverarbeitung durch LLMs

Large Language Models (LLMs) wie GPT, Claude oder Gemini sind neuronale Netzwerke, die mit riesigen Mengen an Textdaten trainiert wurden. Sie können Sprachmuster erkennen, Bedeutungen interpretieren und Texte generieren. In einer KI-Suchmaschine übernehmen sie die Rolle eines Sprachverstehens- und Antwortgenerators: Sie analysieren die Suchanfrage in natürlicher Sprache, verarbeiten relevante Inhalte aus dem Index oder Webzugriff und formulieren daraus eine neue, zusammenhängende Antwort.

Dabei bewerten sie den Kontext, ziehen Informationen aus mehreren Quellen zusammen und können sogar Widersprüche oder Redundanzen erkennen.

“Während Google mit seinem riesigen Webindex und integrierten Systemen weiterhin einen strukturellen Vorteil besitzt, müssen KI-basierte Systeme wie ChatGPT erst externe Datenquellen ansteuern und Inhalte scrapen, um Antworten zu liefern.” (Johannes Beus im OMT Podcast)

Konsequenzen für Websites und SEO

Mit der Verschiebung von Link-basierten Ergebnissen hin zu generierten Antworten verändern sich die Spielregeln für Sichtbarkeit im Netz. Das zentrale Problem lautet: Wenn die Antwort bereits auf der Suchergebnisseite erscheint, entfällt der Klick auf die eigentliche Website. Dieses sogenannte „Zero-Click“-Phänomen führt dazu, dass organischer Traffic sinkt, selbst wenn die eigene Seite inhaltlich korrekt zitiert oder verwendet wird.

Seit Einführung der AI Overviews sehen viele Seiten starke Verluste ihres Traffics von Google, je nach Thema. Allerdings betreffen die Verluste besonders häufig generische Themen wie die Suche nach einfachen Fakten, Zahlen oder Namen.

Für SEO bedeutet das eine strategische Erweiterung: Ein gutes Ranking bei Google bleibt zwar wichtig, reicht aber nicht mehr aus. Unternehmen müssen ihre Inhalte so aufbereiten, dass sie nicht nur sichtbar, sondern auch als zitierfähige Grundlage für KI-generierte Antworten herangezogen werden.

Wer regelmäßig zu seinem Fachgebiet in KI-Antworten genannt wird, stärkt seine Marke, baut Autorität auf und kann so langfristig Reichweite und Vertrauen sichern, selbst dann, wenn der direkte Traffic zurückgeht.

Neue SEO-Prinzipien treten in den Vordergrund:

- Vertrauenswürdigkeit: Inhalte müssen so erstellt werden, dass sie für ein KI-System als glaubwürdig, verlässlich und zitierfähig gelten. Die Kriterien, die Google unter E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) zusammenfasst, gelten auch für andere Systeme.

- Strukturierte Inhalte: Klare, prägnante Antworten, FAQ-Blöcke, strukturierte Daten (Schema.org) helfen KI-Systemen, Inhalte korrekt zu erfassen und zu extrahieren.

- Fragenorientierte Inhalte: Wer Content so aufbereitet, dass er konkrete Nutzerfragen direkt beantwortet, erhöht die Chance, in generierten KI-Antworten zu erscheinen.

- Markenbildung und Wiedererkennbarkeit: In einem Umfeld, in dem Inhalte anonymisiert verarbeitet werden, wird es umso wichtiger, eine erkennbare, vertrauenswürdige Marke aufzubauen.

Um die Verluste nachlassender Klicks auszugleichen, müssen mehr und relevantere Inhalte erstellt werden, die nicht nur allgemeine Antworten geben, die Sprachmodelle längst verinnerlicht haben, sondern einen echten Mehrwert bieten: neue Informationen, menschliche Bewertungen und eigene Perspektiven können Sprachmodelle nicht bieten. Wer einfach nur bereits bekanntes Allgemeinwissen zusammenfasst und als Text veröffentlicht, hat künftig keine Chance mehr auf Reichweite über Suchmaschinen. Das können Sprachmodelle heute bereits besser.

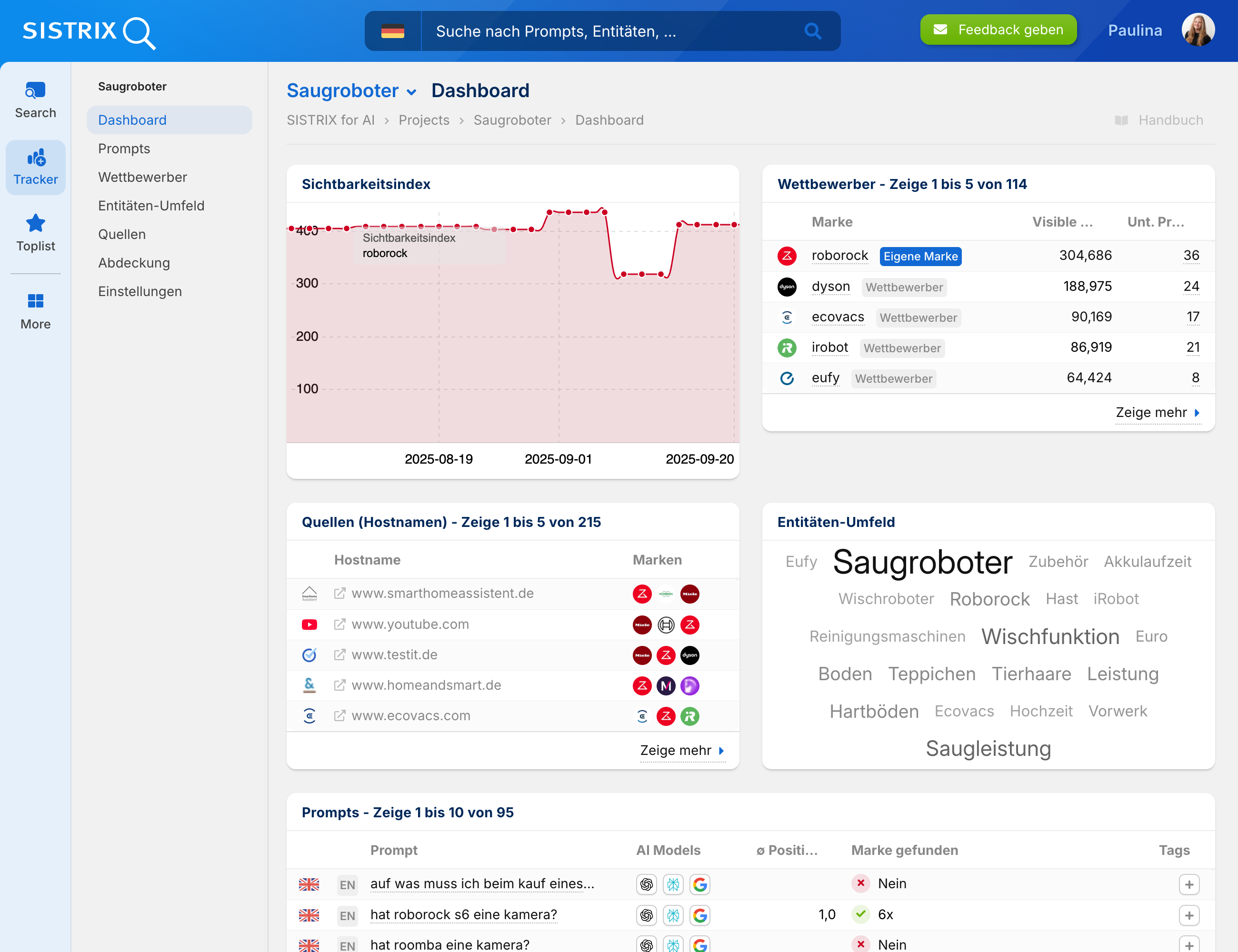

KI-Sichtbarkeit mit SISTRIX messen

Um diese neuen Herausforderungen messbar zu machen, braucht es verlässliche Daten. Genau hier setzt die SISTRIX AI-Chatbot-Beta an: Ein individuelles Projekt zeigt, in welchen Antworten von ChatGPT, Perplexity oder den Google AI Overviews eine Marke auftaucht, welche Links gesetzt werden und wie sich die Sichtbarkeit im Zeitverlauf entwickelt. Damit wird nachvollziehbar, welche Inhalte tatsächlich in generierten Antworten genutzt werden und wie sich die eigene Position im Wettbewerbsumfeld verändert.

Projekt anlegen

Mit dem Anlegen eines Projekts und dem Hinterlegen einer Marke erstellt SISTRIX automatisch ein Wettbewerber-Umfeld und legt die passenden Prompts an. So erhältst du eine strukturierte Grundlage, um deine Sichtbarkeit in KI-Antworten regelmäßig zu beobachten.

Außerdem berechnet SISTRIX sofort einen eigenen Sichtbarkeitsindex für deine Marke – so wie es den Index bereits für Google und Amazon gibt. Dieser Index basiert auf den aktuellen Daten und bietet die ideale Metrik, um Erfolge im neuen Umfeld von KI-Suchmaschinen messbar zu machen.

Zusätzlich werden sofort weitere Bausteine aufbereitet:

- Wettbewerber – zeigt, welche Marken in deinem Umfeld ebenfalls sichtbar sind

- Quellen – listet die Inhalte, aus denen die Antworten der KI-Systeme stammen

- Entitäten-Umfeld – analysiert zusammenhängende Begriffe, Marken und Themen

- Prompts – dokumentiert die verwendeten Fragen und Antworten im Detail

So entsteht direkt nach Projektstart ein vollständiges Bild deiner Sichtbarkeit in KI-Suchmaschinen – mit Kennzahlen, Quellen und Wettbewerbern im Überblick.

Prompts im Detail

Alle angelegten Prompts lassen sich im Detail analysieren. In der Übersicht siehst du, welche Prompts abgefragt wurden, in welchen KI Systemen sie getestet werden und ob deine Marke darin vorkommt. Klickst du auf einen Prompt, zeigt die Detailansicht zuerst den zeitlichen Verlauf der Nennungen und macht sichtbar, wie sich die Sichtbarkeit über Tage oder Wochen entwickelt.

Darunter stehen die gespeicherten Antworten der Systeme. Sie werden fortlaufend archiviert, sodass sich Veränderungen leicht vergleichen lassen. Nennungen und Verlinkungen deiner Marke oder der Wettbewerber werden hervorgehoben. So erkennst du, welche Inhalte in die Antworten einfließen und wie sich die Darstellung im Zeitverlauf verändert.

Wettbewerber im Blick

Die Wettbewerber Analyse zeigt automatisch, welche Marken neben der eigenen in KI Antworten genannt werden. Im Sichtbarkeitsindex werden die wichtigsten Wettbewerber direkt mit der eigenen Marke verglichen. So lässt sich auf einen Blick erkennen, wie sich die Sichtbarkeit im Markt verteilt. Ergänzend dazu steht eine vollständige Liste aller erkannten Wettbewerber bereit – inklusive Sichtbarkeitsindex, Nennungen in den definierten Prompts und Anzahl unterschiedlicher Prompts.

Analysiere mit SISTRIX, wie sichtbar deine Marke in KI-Suchmaschinen wirklich ist. Mit der AI/Chatbot-Beta erkennst du, in welchen KI-Antworten deine Marke genannt wird, welche Quellen dafür herangezogen werden und wie sich die Sichtbarkeit im Zeitverlauf verändert. Teste SISTRIX 14 Tage kostenlos und analysiere die Sichtbarkeit deiner Marke auch in den neuen Suchsystemen.

KI-Suchmaschinen vs. KI-Chatbots mit Web-Zugriff

KI-Suchmaschinen

Diese Systeme wurden von Beginn an dafür entwickelt, die klassische Websuche durch KI zu ersetzen oder zu erweitern. Sie kombinieren in der Regel einen eigenen Webcrawler, einen Index und ein Sprachmodell, das aus den gefundenen Inhalten eine Antwort generiert.

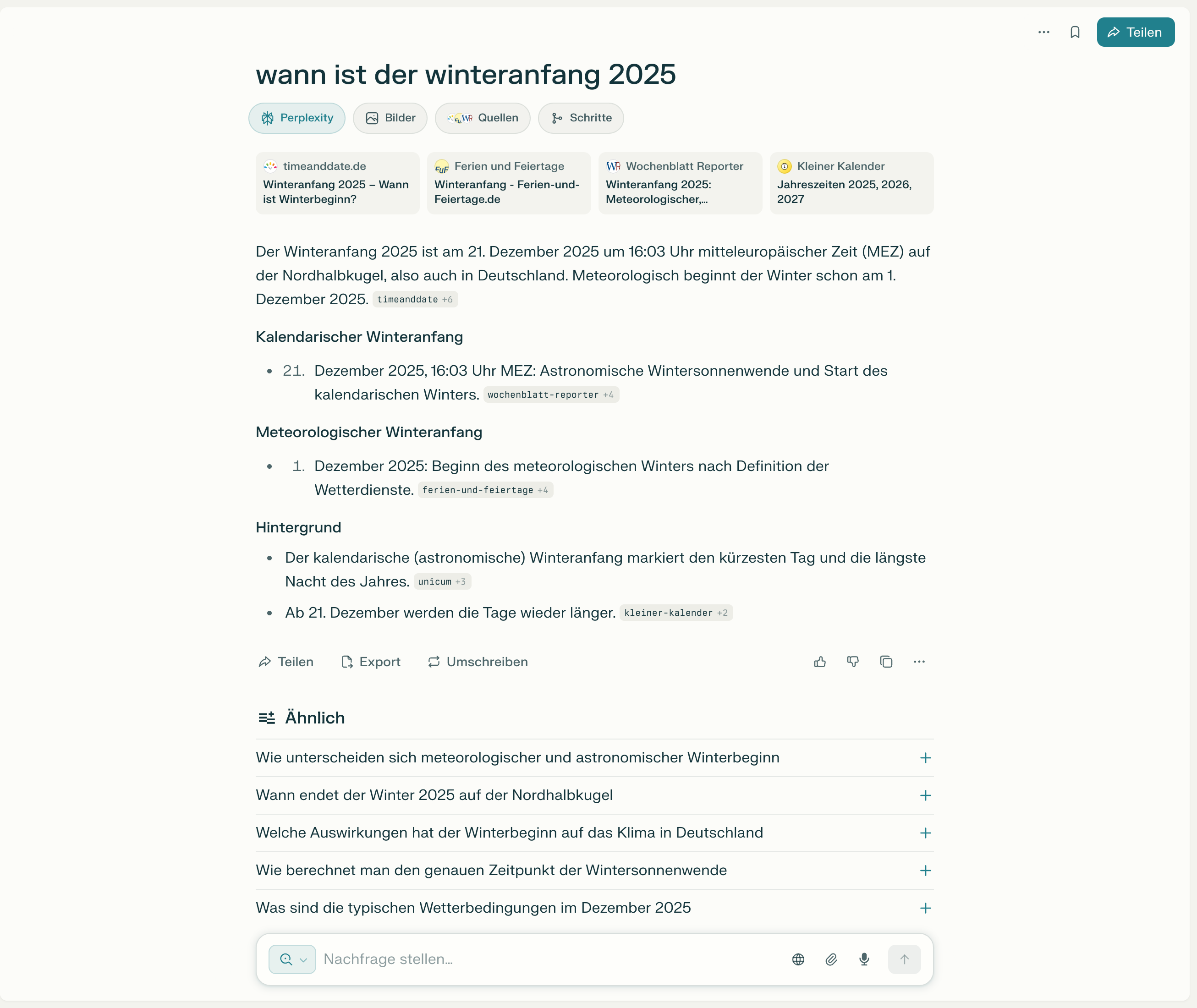

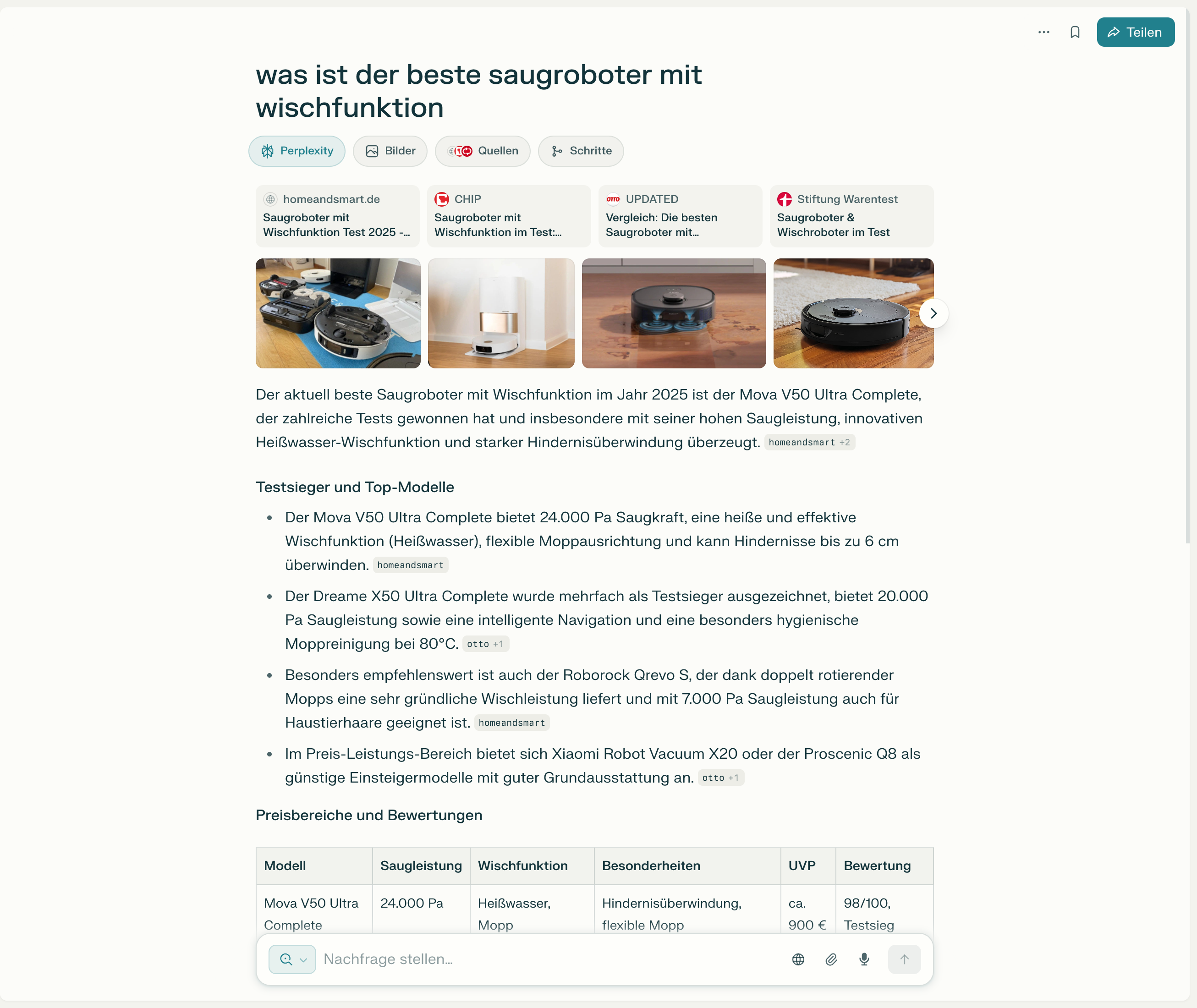

Perplexity AI gehört zu den bekanntesten Vertretern dieser Kategorie. Der Dienst durchsucht mit eigenen Crawlern das Internet, analysiert die Inhalte und speichert sie in einem eigenen Index. Bei einer Suchanfrage werden relevante Quellen identifiziert, die Inhalte analysiert und durch ein Sprachmodell in eine vollständige Antwort verwandelt, ergänzt durch transparente Quellenangaben. Perplexity versteht sich nicht als Suchmaschine im klassischen Sinn, sondern als Antwortmaschine für tiefergehende Informationsbedürfnisse. Die Suchergebnisse von Perplexity ähneln allerdings auffällig oft jenen von Google, sodass davon auszugehen ist, dass Perplexity und andere KI-Suchmaschinen auch auf die Google-Suchergebnisse zugreifen, um passende Antworten zu finden.

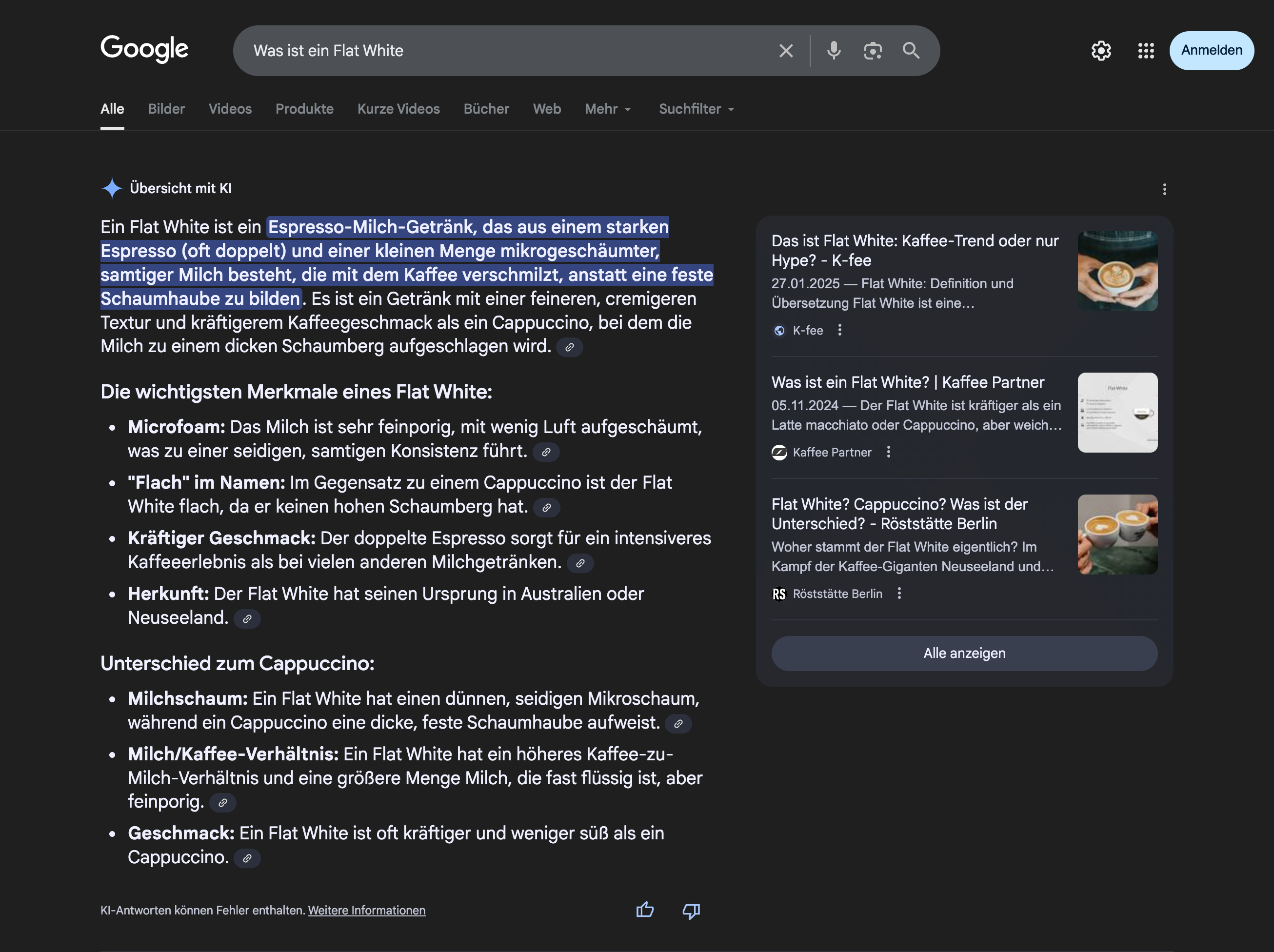

Google AI Overviews (ehemals Search Generative Experience) ist Googles Ansatz, die traditionelle Suche mit generativer KI zu verbinden. Grundlage ist der Google-Index, kombiniert mit KI-generierten Zusammenfassungen, die über den normalen Suchergebnissen angezeigt werden. Die Antworten erscheinen wie ein begleitender Kommentar zur Trefferliste, nicht als Ersatz, sondern als Kontextualisierung. Sie enthalten aber häufig so umfangreiche Informationen, dass ein Klick auf die Suchergebnisse für viele Fragen gar nicht mehr notwendig ist. Eine Studie zeigt einen durchschnittlichen Verlust von 50% Klicks in Google seit Einführung der AI Overviews. Der Google AI Mode könnte die Klickraten sogar noch weiter reduzieren.

You.com verfolgt einen modularen Ansatz. Nutzer können wählen, ob sie klassische Links, KI-Zusammenfassungen oder beides sehen möchten. Auch hier kommen ein eigener Crawler und ein Sprachmodell zum Einsatz. You.com versucht, die Suche stärker zu personalisieren, indem es Ergebnisse anpasst und Nutzern erlaubt, das Layout ihrer Ergebnisse selbst zu steuern.

Allen drei Systemen gemeinsam ist, dass sie nicht bloß „sprechende Interfaces“ sind, sondern eigene technische Infrastruktur zur Erfassung und Bewertung von Webinhalten betreiben. Sie sind damit mehr als nur Frontends für bestehende Suchmaschinen.

KI-Chatbots mit Web-Suche

Diese Systeme wurden ursprünglich als Sprachmodelle für allgemeine Konversationen konzipiert, erhielten jedoch später Funktionen zur Echtzeit-Informationsbeschaffung durch Webzugriff. Sie verfügen in der Regel nicht über eigene Crawler oder einen vollständigen Suchindex, sondern nutzen bestehende Suchdienste wie Google oder Bing.

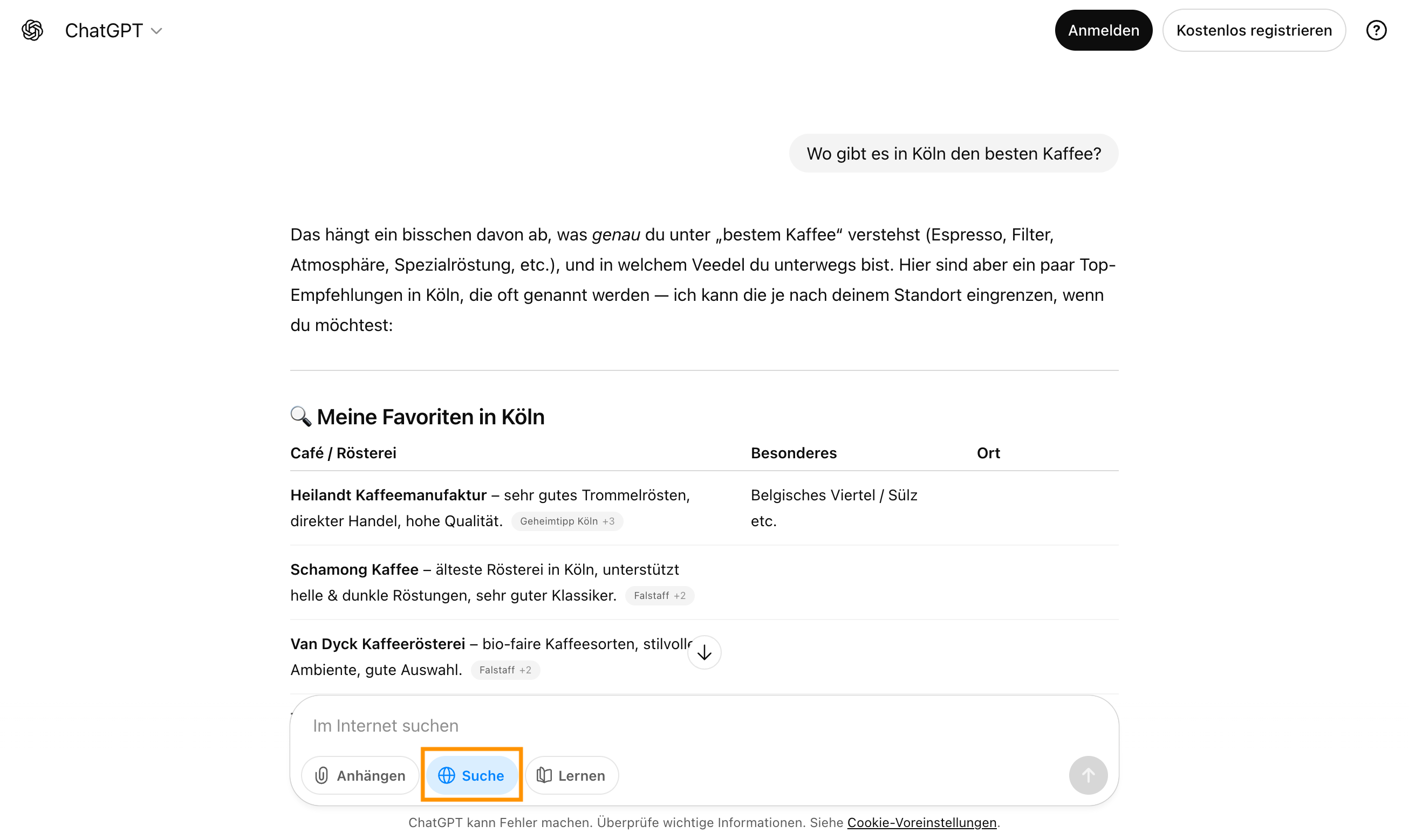

ChatGPT mit Browsing-Funktion kann bei aktivierter Browsing-Funktion das Web durchsuchen. Das Modell sendet eine Suchanfrage an eine bestehende Suchmaschine – etwa Bing oder Google – liest eine Auswahl der angezeigten Seiten aus und verarbeitet deren Inhalte zur Beantwortung der ursprünglichen Nutzerfrage. Dabei erfolgt kein dauerhaftes Crawling, sondern ein temporärer Zugriff zur Laufzeit der Konversation. Quellen werden in der Regel angegeben, allerdings bleibt die Suchlogik des zugrunde liegenden Dienstes (z. B. Bing) im Hintergrund.

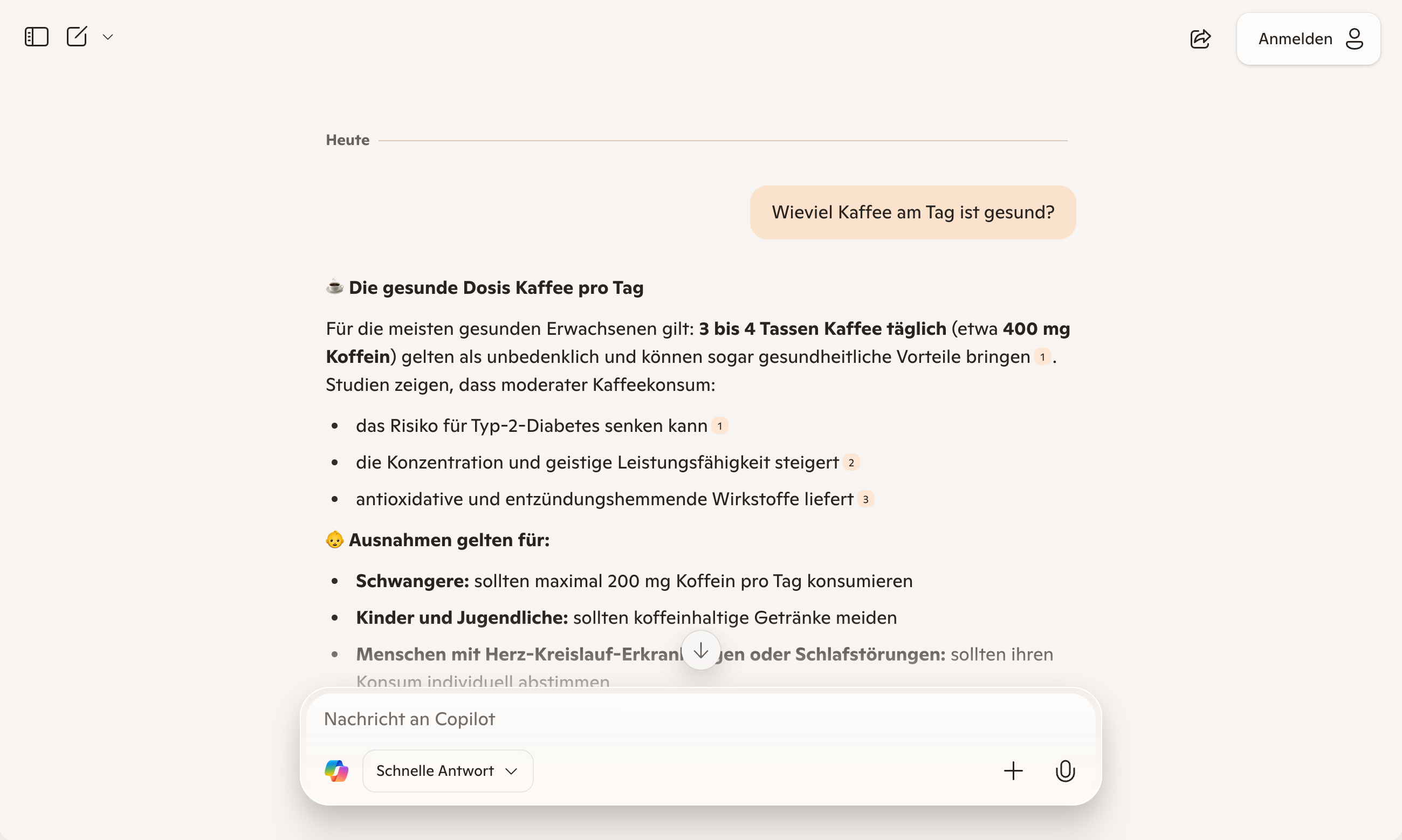

Microsoft Copilot (früher Bing Chat) ist tief in das Bing-Ökosystem integriert. Die Sprachverarbeitung erfolgt über ein GPT-Modell, das auf Echtzeitzugriffe auf den Bing-Suchindex zurückgreifen kann. Copilot kann damit Suchanfragen analysieren, relevante Inhalte abrufen und direkt in eine generierte Antwort einbauen. Die technische Kontrolle über Suche und Sprachmodell liegt bei Microsoft, was eine tiefe Integration erlaubt, etwa in Edge, Windows und Office-Produkte.

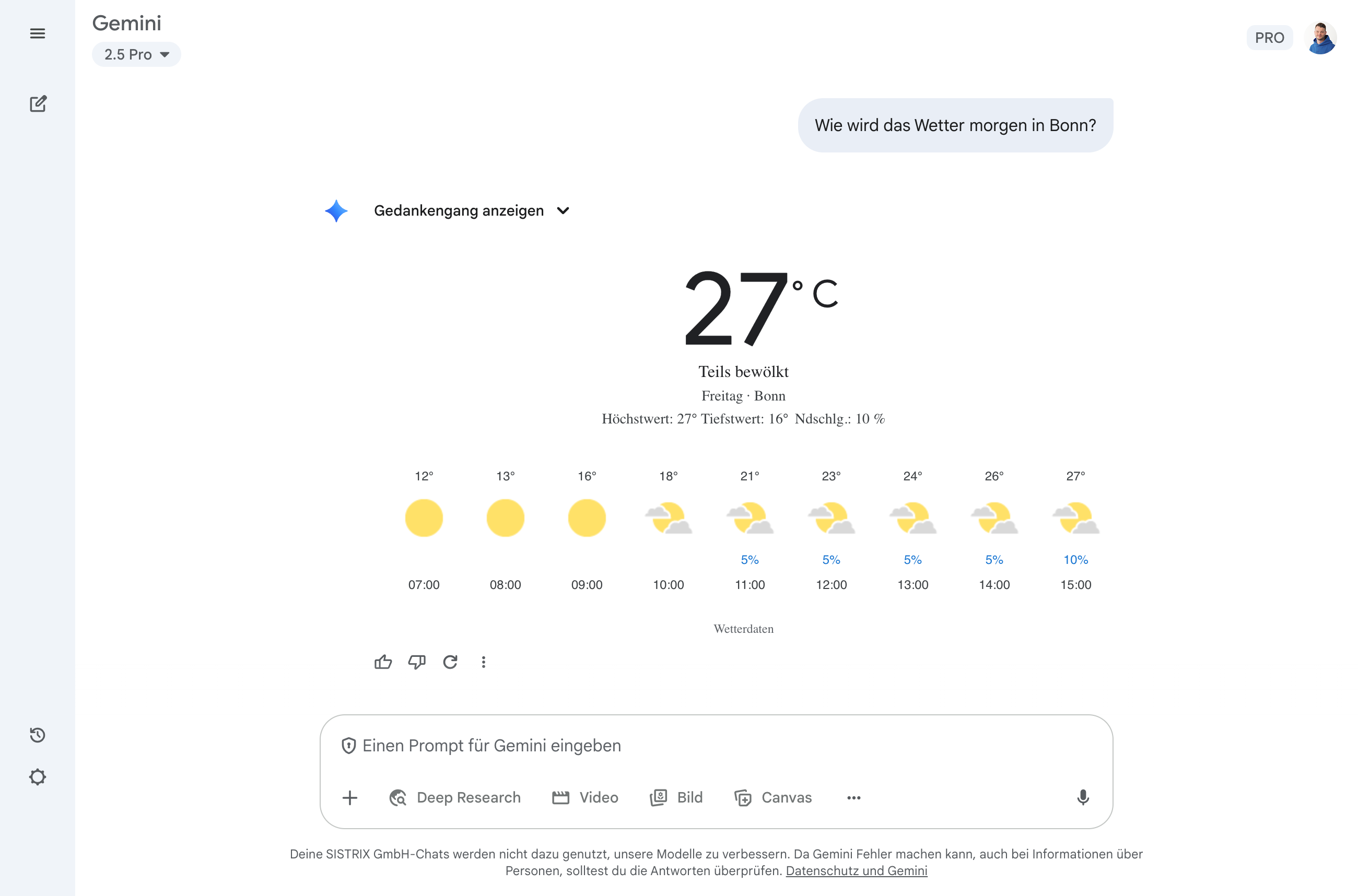

Google Gemini verfügt in bestimmten Modi über Webzugang, etwa über „Gemini in Chrome“ oder den Live-Modus in der Web-App. Dabei greift das Modell nicht auf einen eigenen Suchindex zu, sondern nutzt ausgewählte Webseiteninhalte in Echtzeit. Der Zugriff ist jedoch eingeschränkt und hängt von Kontotyp, Sprache und Region ab, sodass Gemini im Unterschied zu Perplexity oder Bing Copilot bislang kein vollwertiges Suchsystem mit eigenem Index darstellt. Die Stärke von Google Gemini ist, dass das Modell auch sehr große Textmengen verarbeiten kann und sich damit vor allem für die professionelle Recherche in umfangreichen Textdokumenten oder Studien eignet.

Im Unterschied zu den reinen KI-Suchmaschinen sind diese hybriden Systeme stärker abhängig von externen Suchinfrastrukturen. Sie durchsuchen nicht das gesamte Web auf eigene Faust, sondern wählen gezielt Seiten aus, die über etablierte Suchmaschinen auffindbar sind. Das zeigt, wie wichtig Suchmaschinen-Rankings auch künftig für die Nennung in KI-Antworten sind.

KI-Chatbots ohne Web-Suche

Neben KI-Suchmaschinen und Chatbots mit Browsing-Funktion gibt es eine dritte Kategorie: Sprachmodelle, die rein auf ihrem Trainingskorpus basieren und keinen Zugriff auf das Web haben. Diese Systeme können Inhalte erstellen, Fragen beantworten oder Texte umformulieren, aber nur auf Grundlage des Wissens, das sie bis zu ihrem Trainingszeitpunkt aufgenommen haben.

- ChatGPT verfügt zwar über eine optionale Websuche, nutzt diese jedoch in den meisten Fällen und bei den meisten Anfragen nicht. Standardmäßig greift das Modell auf seinen umfangreichen Wissensstamm zurück, der aus den Trainingsdaten besteht. Nur wenn die Browsing-Funktion aktiv eingeschaltet ist oder ChatGPT selbst entscheidet, dass aktuelle Daten benötigt werden, erfolgt ein Zugriff auf das Web.

- Claude (Anthropic) ist darauf spezialisiert, längere Kontexte zu verarbeiten, Texte zu analysieren und verständlich zusammenzufassen. Es verfügt jedoch über keinen eingebauten Webzugang. Wenn Claude eine Frage beantwortet, stützt es sich ausschließlich auf das, was im Trainingsmaterial enthalten war oder was der Nutzer im Chat bereitstellt (z. B. durch Datei-Uploads oder Texteingaben).

- LLaMA (Meta) und darauf basierende Open-Source-Modelle wie Mistral oder Falcon gehören ebenfalls in diese Kategorie, wenn sie lokal oder ohne Anbindung an zusätzliche Suchdienste betrieben werden.

Ausblick: Wird die KI-Suche die klassische Suche verdrängen?

Die schnelle Verbreitung von KI-Systemen wie ChatGPT zeigt, dass die direkte Antwort ohne Klick für Nutzer sehr attraktiv ist, besonders für einfache W-Fragen und die mobile Nutzung.

Allerdings ist die Qualität der Antworten häufig nicht so zuverlässig, wie man es von einer Suchmaschine erwarten muss. Google hat kürzlich seinen „Web Guide“ vorgestellt und verbindet darin kurze KI-generierte Antworten direkt mit den Quellen als klassische Linkliste und zeigt damit, in welche Richtung es künftig gehen könnte, um die Quellen ausreichend zu würdigen: KI-Antworten plus Linkliste. So bekommen Nutzer schnelle Antworten und die Quellen trotzdem weiterhin Klicks von denjenigen, die es genauer wissen wollen und mehr Kontext zum Thema brauchen.

SISTRIX kostenlos testen

- Kostenloser Testaccount für 14 Tage

- Unverbindlich, keine Kündigung notwendig

- Persönliches Onboarding durch Experten