Es gibt unzählige Beispiele für einen aus SEO-Sicht schlecht durchgeführten Relaunch, bei dem die betroffene Website einen große Teil der Rankings verliert. Um so schöner ist es, dass es mit giga.de ein Beispiel für einen bislang sehr erfolgreichen Relaunch gibt. Die Website des ehemaligen TV-Senders GIGA wurde im März 2011 von der Econa Internet AG übernommen. Econa hat sich darauf spezialisiert bereits profitable mittelgroße Websites mit gutem Conent aufzukaufen und weiterzuentwickeln.

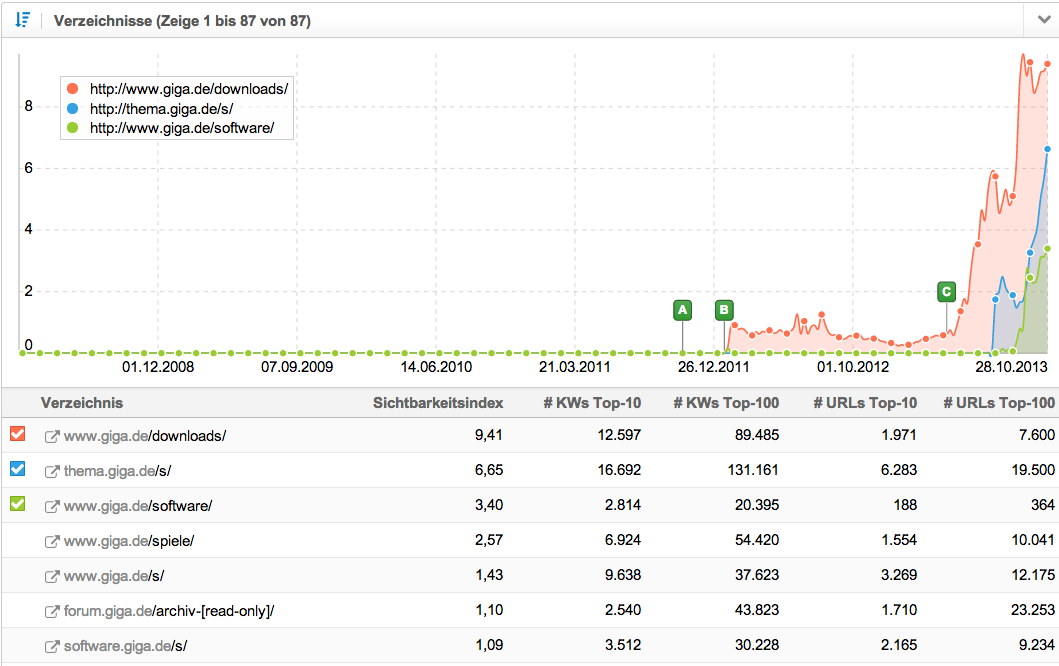

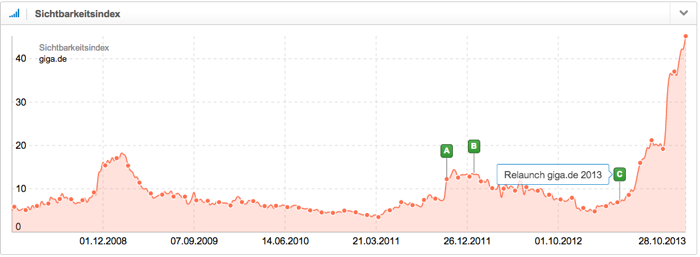

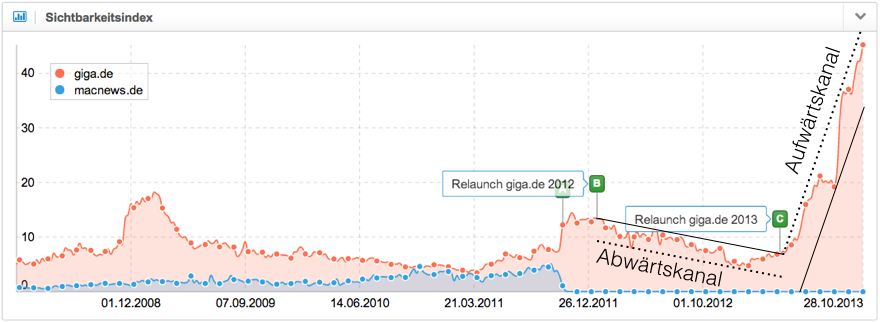

Zuletzt führte giga.de Anfang April 2013 (Ereignis-Pin C) einen Relaunch durch. Der Sichtbarkeitsindex ist seit diesem Zeitpunkt von 6,8 Punkte auf über 45 Punkte gestiegen und hat sich damit mehr als versechsfacht. Insbesondere für Betreiber von Newsportalen und Blogs ist giga.de damit ein sehr interessantes Best-Practice-Beispiel, bei dem man sich einige SEO-Techniken abschauen kann.

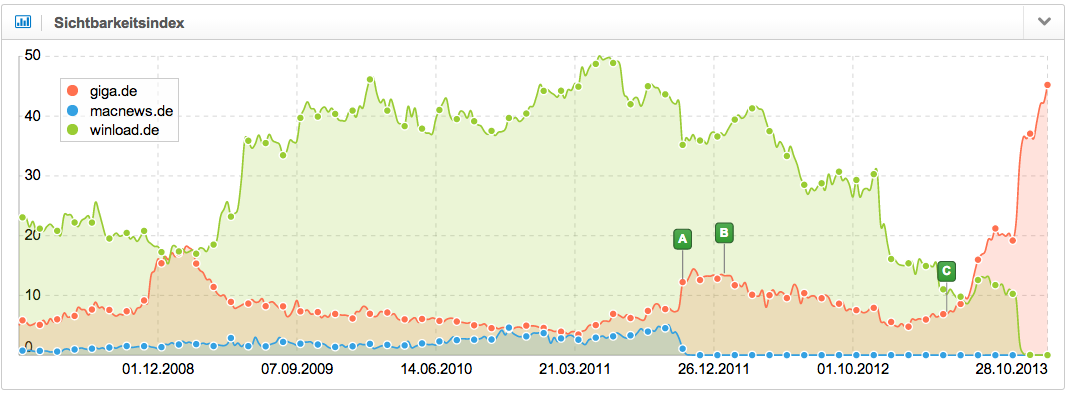

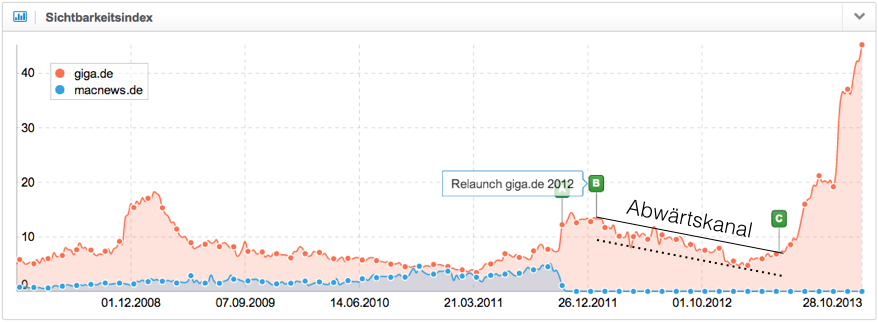

In den letzten Jahren haben insbesondere drei Ereignisse die Entwicklung der Sichtbarkeit von giga.de stark beeinflusst.

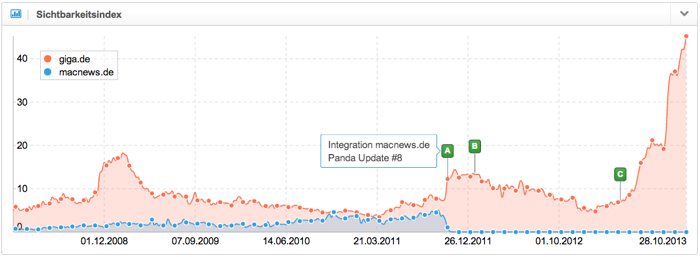

A) Integration von macnews.de (Ereignis-Pin A)

Nach der Übernahme durch Econa konnte giga.de den langfristigen Abwärtstrend im Sichtbarkeitsindex durchbrechen und in einen Aufwärtstrend umwandeln. Eine richtigen Sprung nach oben gab es in der Woche vom 24.11.2011 (Ereignis-Pin A).

Zu diesem Zeitpunkt hatte Econa die im gleichen Jahr erworbene Plattform macnews.de auf giga.de überführt. Ebenfalls wurden 2011 die kleineren Portale macmagazin.de und maccommunity.de übernommen. Die Sichtbarkeit von macnews.de konnte weitestgehend auf giga.de übertragen werden. Mit dieser Aktion schaffte es giga.de in die Liste der SISTRIX IndexWatch Gewinner 2011 und wir haben darauf hingewiesen, dass solche Mergers & Acquisitions in Zukunft ein interessantes Wachstumsmodell im SEO-Bereich sind, um schnell mehr Links und mehr Content zu realisieren.

B) Relaunch giga.de Januar 2012 (Ereignis-Pin B)

Es ist noch kein Meister vom Himmel gefallen und mit dem Relaunch von giga.de im Januar 2012 mußte auch Econa erst einmal Lehrgeld bezahlen. Während technisch offenbar alles richtig gemacht wurde und ausreichend 301-Weiterleitungen gesetzt wurden, zeigt eine Lektüre der über 200 Kommentare zur Neugestaltung der Website deutlich, dass viele Leser sehr unzufrieden mit dem neuen Design waren. Sie empfanden die neue Website unübersichtlich und hatten teilweise Probleme Werbung und redaktionelle Inhalte zu unterscheiden. Man kann davon ausgehen, dass sich diese Unzufriedenheit auch in schlechter werdenden Nutzersignalen äußerte, die von Google gemessen werden können (z.B. CTR in den SERPs, Return-to-SERP-Rate usw.). Entsprechend bildete sich ab dem 16.01.2012 ein deutlicher Abwärtskanal im Sichtbarkeitsindex.

Der Zugewinn durch die Integration von macnews.de war schnell aufgebraucht und der Sichtbarkeitsindex fiel auf Werte aus der Zeit vor der Übernahme durch Econa. Dieser „langsame Tod“ ist häufig bei Websites zu beobachten, bei denen die Nutzersignale (z.B. durch zu starke Integration von Werbung, schlechte Usability, oder Content mit geringem Mehrwert) nicht mehr wettbewerbsfähig sind. Typisch für so eine Entwicklung sind auch stärkere Reaktionen der Sichtbarkeitskurve auf Panda-Updates von Google an die Grenzen des Trendkanals.

C) Relaunch giga.de April 2013 (Ereignis-Pin C)

Econa hat aus seinen Fehlern gelernt und bei einem erneuten Relaunch von giga.de im April 2013 (Ereignis-Pin C) sehr viele Dinge richtig gemacht. Die Sichtbarkeit bei Google befindet sich seither in einem steilen Aufwärtskanal.

Einen interessanten Einblick liefert das Interview mit dem Leiter der Apple-Redaktion Sven Kaulfuss:

„Wir haben unsere Leser erhört. Sie waren mit dem Relaunch 2012 nicht zufrieden und haben das deutlich zum Ausdruck gebracht – entweder in den Kommentaren oder indem sie der Website ganz fern geblieben sind. Diese Kritik haben wir uns zu Herzen genommen und deshalb in den letzten Monaten an einem weiteren Relaunch gearbeitet.“

Der Relaunch hat aber nicht nur die Leser erhört, sondern auch dem Googlebot das Leben einfacher gemacht. Auf giga.de kommen viele zeitgemäße SEO-Techniken zum Einsatz, von denen ich fünf ausgesuchte Punkte gerne beleuchten möchte.

1) Den Nutzer in den Mittelpunkt stellen

Das Zitat von Sven Kaulfuss beschreibt bereit einer der wichtigsten SEO-Maßnahmen von giga.de, die Ausrichtung der Website auf die Bedürfnisse der Nutzer. In den letzten Jahren ist Google immer besser darin geworden Qualitätsfilter zu entwickeln, die Treffer mit schlechten Nutzersignalen aus den vorderen Suchergebnissen ausfiltern. Die Panda-Updates sind sicherlich die bekanntesten dieser Filter, aber auch die Google Page Layout Algorithm Updates un weitere unkommunizierte Verbesserungen der Google-Algorithmen und Filter kann man hinzuzählen.

Langfristig halten sich Treffer trotz bester Optimierung nicht in den Top-10, wenn die von Google gemessenen Qualitäts- und Nutzersignale gegenüber den anderen Treffern nicht wettbewerbsfähige Kennzahlen abliefern. Schließlich möchte Google seine Nutzer besmöglich zufriedenstellen, um die führende Suchmaschine zu bleiben.

Die klassischen Rankingfaktoren sind anfällig für SEO-Manipulationen. Zusätzliche Qualitätsfilter sind die logische Konsequenz. Den Bedürfnisse des Nutzers zu erkennen und eine zufriedenstellende Antwort zu liefern hat das SEO-Betätigungsfeld erweitert und wird endlich auch von Google belohnt.

2) Strukturierung der Inhalte mit Themenseiten

Gerade im Newsbereich und bei Blogs besteht immer das Problem, dass man eine Vielzahl von Artikeln bzw. URLs zu einem bestimmten Keyword besitzt, die sich inhaltlich überschneiden und gegenseitig ergänzen. Weder der Websitebetreiber noch Google könnten eine vernünftige Antwort geben, welcher dieser Seiten für das Keyword am besten oben stehen sollte. Jeder Artikel beleuchtet das Thema mit seinen eigenen Detailinformationen und hat seine Berechtigung.

Die Lösung sind hier Themenseiten, welche diese Artikel in einer Übersicht bündeln. Auf diese Weise läßt sich eine unstrukturierte Ansammlung von News und Beiträge in eine strukturierte Form bringen, die beständigere Rankings ermöglicht und von Google besser verstanden wird. In dem Beitrag „Themenseiten“ haben wir den Erfolg dieser SEO-Technik näher beleuchtet.

Bei giga.de wurden die Inhalte nach Kategorien wie z.B. Downloads, Software, Spiele und Unternehmen strukturiert und für jedes Keyword in das passende Verzeichnis eine entsprechende Themenseite erstellt. Eine Analyse der Sichtbarkeitsentwicklung der einzelnen Verzeichnisse von giga.de zeigt den Erfolg dieser Maßnahme seit dem Relaunch 2013.

Auch die Umsetzung der Themenseiten ist bei giga.de überdurchschnittlich gut gelungen. Sie stellen oft nicht nur einer interne Suchergebnisseite dar, was Google als unerwünschte „SERPs-in-SERPs“ (Suchergebnis-Seiten als Treffer in den Suchergebnissen von Google) werten könnte. Vielmehr bieten sie oft eine echte Übersicht zum Thema mit Mehrwert für den Nutzer. So findet man z.B. auf der Seite zum iPhone 5s eine sehr ausführliche Beschreibung des Produktes, Fakten zum Produkt, Links zu den meistdiskutierten Artikeln, Tests, Tipps, ähnlichen Produkten usw.

Diese Seiten heben sich angenehm von den vollautomatisierten Themenseiten anderer Websites ab. Man merkt, dass man sich hier ein paar Gedanken über die Inhalte gemacht hat, was die Nutzer interessieren könnte, um sie tiefer in die Website zu ziehen und weitere Klicks zu erzeugen. Offensichtlich war man auch bereit darin etwas Arbeit zu investieren. Für den Suchbegriff „iPhone 5s“ steht giga.de mit seiner Themenseite übrigens derzeit auf einem guten Platz 5 bei Google (Rankingentwicklung anzeigen).

3) Intensive interne Verlinkung

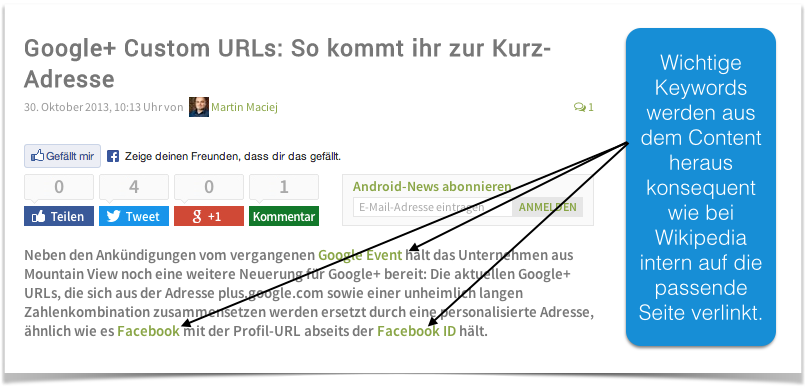

Die Themenseiten müssen mit Links versorgt werden. Während man bei externen Keyword-Links schnell in einen Google-Filter geraten kann, hilft man mit internen Keyword-Links Google die Inhalte der Website besser zu verstehen. Davon macht giga.de ausreichend Gebraucht. Konsequent wird aus dem Content heraus jedes Keyword auf die passende Themenseite verlinkt, wenn es erstmalig auf einer Seite im Text erscheint. Häufig sind die Keywords auch schon im Anreißer eines Artikels verlinkt, so dass die Links bereits auf den Übersichtsseiten wirken. Der folgende Screenshot zeigt als Beispiel drei interne Keywordlinks am Angang des heutigen Artikels über Google+ Custom URLs.

Diese Technik erinnert insgesamt ein wenig an die interne Verlinkung bei Wikipedia und der SEO-Erfolg des Lexikons sollte jedem bekannt sein. Auch wenn Wikipedia diese Form der internen Verlinkung wahrscheinlich nicht aus SEO-Gründen umgesetzt hat, sondern weil sie ebenfalls für die Nutzer sehr praktisch ist und gerne angenommen wird. Diese sehr mächtige SEO-Technik haben wir in dem Beitrag „Interne Verlinkung optimieren“ für eine tiefere Auseinandersetzung mit dem Thema ausführlich behandelt.

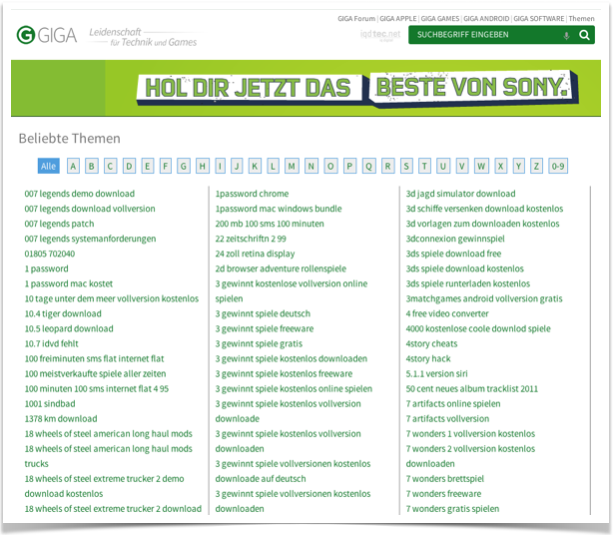

4) HTML-Sitemap

Neben der unter Punkt 3) beschriebenen internen Verlinkung macht es eine Art HTML-Sitemap dem Googlebot sehr einfach, wirklich alle gewünschten Seiten schnell zu finden, deren Bedeutung und Inhalt anhand des verwendeten Linktextes zu verstehen und Linkjuice zu verteilen.

Im Header und Footer wird sehr intensiv auf beliebte Themen verlinkt und die Keywordlisten zu den einzelnen Themenseiten sind über eine A-Z-Liste mit Hunderten von Seiten leicht crawlbar.

Darüber hinaus gibt es weitere Übersichts- und Verteilerseiten, welche die Inhalte über verschiedene Kategorisierungen schnell zugänglich machen. Auf diese Weise kann sichergestellt werden, das auch wirklich alle gewünschten Seiten gezielt indexiert und mit einem Mindestmaß an PageRank versorgt werden.

Im Vergleich zu XML-Sitemaps bieten HTML-Sitemaps den großen Vorteil, dass sie (interne) Backlinks und damit Rankingsignale erzeugen. Die Seiten sollen schließlich nicht nur indexiert werden, sondern auch gute Positionen bei Google erreichen.

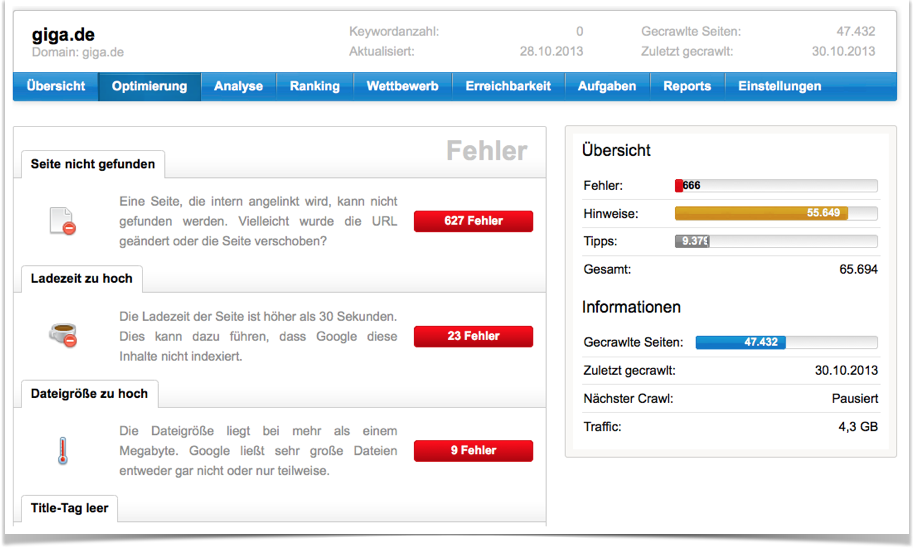

Für diesen Blogpost haben wir gestern im SISTRIX Optimizer für giga.de ein neues Projekt angelegt und bis heute hat er dort 47.432 Seiten gecrawlt.

Die Analyse bestätigt die Vermutung, dass die „Durchblutung“ durch interne Links bei giga.de sehr gut ist. So zeigt z.B. die Analyse der Klick-Ebenen, dass über 14.000 Seiten mit maximal 2 Klicks von der Startseite aus erreichbar sind. Das ist ein sehr guter Wert.

Die Analyse der internen Linktexte ergibt, dass auf den untersuchten Seiten beispielsweise 17.567 Links den Anchor-Text „iPhone 5s“ verwenden. Eine dermaßen intensive Verlinkung wie in den Punktn 3) und 4) beschrieben liefert Google natürlich wesentlich stärkere Signale als nur 1–2 Links von einer übergeordneten Seite, wie man es bei vielen anderen Websites häufig beobachtet.

Die folgende Tabelle zeigt einige Beispiele der am häufigsten verwendeten internen Linktexte bei giga.de mit der Anzahl gefundener Links.

5) Keyword-Recherche

Es werden nicht nur die sicherlich schwierigen Hauptkeywords wie z.B. „Google Chrome“ angegangen. Zu vielen Keywords gibt es Themenseiten, die z.B. noch einmal unterteilt werden in Tests, News, Artikel und Tipps und auf Detailseiten verlinken, die dann im Longtail ganz unterschiedliche Keywordkombinationen und verwandte Suchanfragen bedienen. Man merkt, dass hier viel Arbeit in die Keyword-Recherche geflossen ist.

6) Gezielte Indexierung

Ein Gärtner beschneidet Pflanzen, damit die ganze Energie in ausgesuchten Triebe fließt und diese besonders gut gedeihen, um so den Ertrag der Pflanze zu maximieren. Weniger ist hier oft mehr. Ähnlich sollte man bei den indexierten Seiten vorgehen und die Website regelmäßig auf das richtige Maß stutzen. Die Rankings der verbleibenden indexierten Seiten werden es einem danken. Man vermeidet damit nicht nur internen Duplicate Content, sondern kann auch verhindern, dass Inhalte mit weniger wertvollen Inhalten die Gesamtbewertung der Domain mit unterdurchschnittlich guten Signalen herunterziehen.

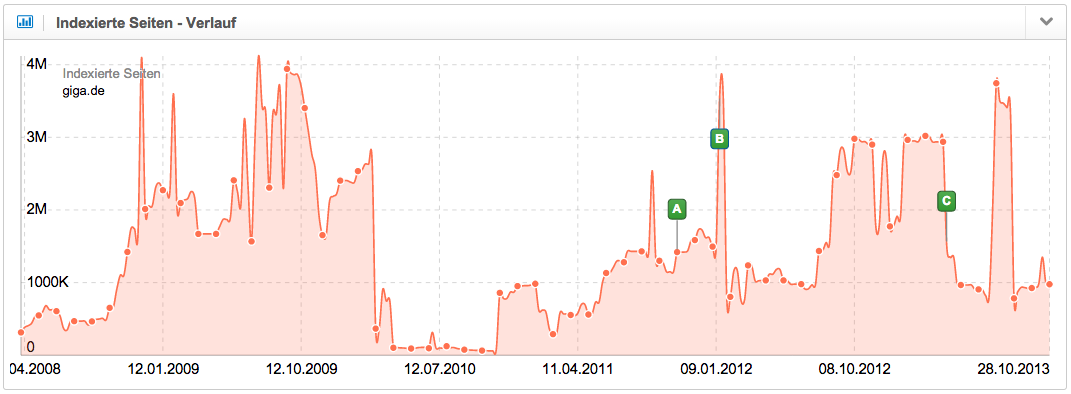

Seit dem Relaunch im April 2013 hat giga.de die Anzahl indexierter Seiten von rund 3 Mio. auf unter 1 Mio. heruntergefahren. Ein zwischenzeitlicher Anstieg der Anzahl indexierter Seiten im Zeitraum Juli bis August 2013 brachte den steilen Aufwärtstrend prompt ins Stottern. Erst als die Anzahl Seiten wieder unter 1 Mio. gesunken war, setzte der Aufwärtstrend wieder ein.

Die Kontrolle der indexierten Seiten gehört bei vielen Websites zu einem der am stärksten vernachlässigten Faktoren. Auch wenn die Werte nur eine grobe Schätzung von Google sind, sollte man sie ganz genau im Auge behalten und ungewöhnlichen Entwicklungen auf den Grund gehen. Weniger wertvolle Inhalte sollten durch NoIndex-Attribute gezielt deindexiert werden, um das Crawling- und Indexierungs-Budget seitens Google optimal einzusetzen und keine negativen Signale zu senden.

Bei giga.de hat man offenbar ein Auge darauf. So werden z.B. Verteilseiten wie diese, diese, oder diese richtigerweise von der Indexierung ausgeschlossen.

Fazit

Die erfolgreiche Entwicklung von giga.de zeigt sehr deutlich wie wertvoll gute Inhalte erst in Verbindung mit einer durchdachten Informationsarchitektur und einer nutzerfreundlichen Gestaltung der Website werden. In seiner täglichen SEO-Arbeit sollte man sich nicht zu sehr davon ablenken jeder kleine Husten von Matt Cuts stundenlang zu interpretieren und jedem der über 200 Rankingfaktoren die gleiche Aufmerksamkeit zu schenken.

Wesentlich fruchtbarer ist es viel Zeit mit der ordentlichen Pflege der Basics, einer durchdachten Informationsarchitektur und der Befriedigung der Nutzerbedürfnisse zu verbringen. Die Entwicklung von giga.de seit dem Relaunch im April 2013 veranschaulicht sehr beeindruckend, was für große Potentiale in vielen Websites schlummern, wenn man die richtigen und großen Hebel bedient.

[Update 30.10.2013 14.40 Uhr]

Ich habe gerade bei Skype die Info bekommen, auch winload.de zu Econa gehört und Mitte 2013 mit giga.de fusioniert wurde (siehe auch Wikipedia). Diese Übernahme ist natürlich ein wichtiger Faktor für den Aufwärtstrend nach dem Relaunch, der hier nicht unerwähnt bleiben soll. Die Domain winload.de hat im Zuge mehrerer Panda-Updates in den vergangenen Jahren viel Sichtbarkeit verloren. Es bleibt abzuwarten, ob diese Panda-Filter in Zukunft, wenn Google genug Daten gesammelt hat, auch bei den übertragenen Inhalten auf giga.de aktiv werden.